Классификация характеров

В целом не может быть абсолютной или универсальной классификации характеров, деления их на типы. Основания для типизации, как правило вводятся исследователем или заинтересованным лицом для того, чтобы в соответствии с имеющейся задачей раздеть людей на группы по преобладающим качествам. Так сходные характеры могут наблюдаться у людей имеющих доминирующие волевые или эмоциональные качества. Соответственно делят характеры на типы: волевой (активный, целеустремленный, деятельный) ; эмоциональный (действующий под влиянием порыва, переживаний) ; рассудочный (оценивающий все с точки зрения разумности).

К. Юнг предложил классифицировать характеры в зависимости от принадлежности к экстравертированному и интравертированному типу.

ОБЩЕЕ ОПИСАНИЕ ТИПОВ

Экстравертированный тип . Характеризуется обращенностью личности на окружающий мир, объекты которого подобно магниту, притягивают к себе интересы, жизненную энергию субъекта, в известном смысле ведет к принижению личностной значимости явлений его субъективного мира.

Интровертированный тип . Для него характерна фиксация интересов личности на явлениях собственного внутреннего мира, которым она придает высшую ценность, необщительность, замкнутость, склонность к самоанализу, затрудненная адаптация.

Возможна также классификация на конфорный и самостоятельный; доминирующий и подчиняющийся; нормативный и анархический и прочие типы.

Черт характера чрезвычайно велико, каждая из черт имеет разную качественную степень выраженности.

Чрезмерную выраженность отдельных черт характера и их сочетаний, представляющую крайние варианты нормы, называют акцентуацией характера . Практическая акцентуация — это предельная величина, крайний вариант проявления нормы. Акцентуации характера свойственна повышенная уязвимость лишь к определенного рода психотравматическим воздействиям, адресованным к так называемому «месту наименьшего сопротивления» данного типа характера при сохранении устойчивости к другим. Это слабое звено в характере человека проявляется только в ситуациях, предъявляющих повышенные требования к функционированию именно этого звена, во всех других ситуациях, не затрагивающих уязвимых точек характера, индивид ведет себя без срывов не доставляя неприятностей ни окружающим, ни себе.

Это слабое звено в характере человека проявляется только в ситуациях, предъявляющих повышенные требования к функционированию именно этого звена, во всех других ситуациях, не затрагивающих уязвимых точек характера, индивид ведет себя без срывов не доставляя неприятностей ни окружающим, ни себе.

В зависимости от степени выраженности различают явные и скрытые (латентные) акцентуации характера. Явные, или выраженные, акцентуации относят к крайней границе нормы и отличаются постоянными чертами определенного типа характера. Скрытая акцентуация представляет собой обычный вариант нормы, выраженный слабо или не выраженный совсем. Такие акцентуации могут проявляться неожиданно под влиянием ситуаций и травм, представляющих требования к месту наименьшего сопротивления, в то время как психогенные факторы иного рода, даже тяжелые, не только не вызывают психических расстройств, но могут даже не выявить типа характера. Оба типа акцентуации могут переходить друг в друга под влиянием различных факторов, среди которых важную роль играют особенности семейного воспитания, социального окружения, профессиональной деятельности и т.

См. также

Характер и темперамент

RSS [email protected]

Классификация типов характера — Реферат

Классификация характера

Попытки построения типологии характеров неоднократно предпринимались на протяжении всей истории психологии. Наиболее и ранняя из них предложена немецким психиатром и психологом Эрнстом Кречмером (1888-1964). Несколько позже аналогичную попытку предпринял его американский коллега У. Шелдон, а в наши дни – Э. Фромм, К. Леонгард, А. Е. Личко и ряд других ученых.

Все типологии исходили из ряда общих идей:

1. Характер человека формируется довольно рано в онтогенезе и на протяжении остальной его жизни проявляет себя как более или менее устойчивый.

2.

Те сочетания личностных черт, которые

входят в характер человека, не являются

случайными. Они образуют четко различимые

типы, позволяющие выявлять и строить

типологию характеров.

3. Большая часть людей в соответствии с этой типологией может быть разделена на группы.

Типы характера Э. Кречмера — классификация темпераментов на основе особенностей телосложения. Кречмер организовал собственную лабораторию конституциональной и трудовой психологи, которой руководил до своей смерти.

Э. Кречмер, обследовав 8 800 человек, выделил и описал по результатам тщательного обследования его пациентов, три наиболее часто встречающихся типа строения тела человека.

·Астенический, или лептосомный,

·Атлетический,

·Пикнический.

Астенический

Атлетический (греч. athletes – борец ) сильное развитие

скелета и мускулатуры- мускулистый,

крепкий, высокий, широкоплечий. Голова

плотная и высокая, сильная шея, а лицо

имеет обычно вытянутую яйцевидную

форму.

Пикнический (греч. pyknos – плотный) — толстый, тучный, средний рост, большой живот, короткая шея. Фронтальные очертания лица напоминают пятиугольник, само же лицо – широкое, мягкое, закругленное (интереснее, чем у атлетического типа и правильнее пикнического).

Диспластический тип — строение бесформенное, неправильное, непропорциональное. Был выделен как дополнительный.

Для доказательства связи между телесными и психическими особенностями людей указанные типы телосложения были соотнесены с тремя основными видами душевных расстройств.

Маниакально-депрессивный (циркулярный) психоз – периодическая смена гиперактивных, аффективно-приподнятых (маниакальных) состояний больного и состояния подавленности (депрессии), пассивности и уныния.

Шизофрения

Эпилепсия – приступы злобно-тоскливого настроения, повышенная раздражительность, вспыльчивость, эгоцентризм, чрезмерная педантичность.

Результаты соотнесения показали высокую корреляцию между этими типами психических заболеваний: циркулярного психоза с пикническим строением тела, шизофрении – с астеническим. Атлетики, которые менее других предрасположены к психическим заболеваниям, обнаруживают некоторую склонность к эпилепсии.

Шизотимик – астеническое телосложение. При расстройстве психики предрасположен к шизофрении. Замкнут, склонен к колебаниям эмоций от раздражения до сухости, упрям, малоподатлив к изменению установок и взглядов. С трудом приспосабливается к окружению, склонен к абстракции. Свойственны такие черты характера как аристократичность и тонкость чувств, склонность к отвлеченным размышлениям и отчужденность, холодность, эгоистичность и властность.

Циклотимик — пикническое телосложение. При нарушении психики предрасположен к маниакально-депрессивному психозу. Является противоположностью шизотимика. Эмоции легко колеблются между радостью и печалью, свободно контактирует с окружением, реалистичен во взглядах. Обладает веселостью, болтливостью, беспечностью, задушевностью, энергичностью, склонностью к юмору и легкому восприятию жизни.

Иксотимик – атлетическое телосложение. При

психических расстройствах предрасположен

к эпилепсии. Спокойный, мало впечатлительный,

со сдержанными жестами, мимикой. Невысокая

гибкость мышления, трудно приспосабливается

к перемене обстановки, мелочен.

Спокойный, мало впечатлительный,

со сдержанными жестами, мимикой. Невысокая

гибкость мышления, трудно приспосабливается

к перемене обстановки, мелочен.

Хотя типология Кречмера была построена умозрительным путем, она содержала в себе ряд жизненно правдивых наблюдений. Впоследствии действительно обнаружилось, что люди с определенным типом строения тела имеют склонность к заболеваниям, которые сопровождаются акцентуациями соответствующих черт характера. Более поздние классификации характеров строились в основном на описаниях этих акцентуаций. Одна из них принадлежит известному отечественному психиатру А.Е. Личко. Она построена на основе наблюдений за подростками.

Акцентуация

характера, по Личко, — это

чрезмерное усиление отдельных черт

характера, при котором наблюдаются не

выходящие за пределы нормы отклонения

в психологии и поведении человека,

граничащие с патологией. Такие акцентуации

как временные состояния психики чаще

всего наблюдаются в подростковом и

раннем юношеском возрасте. Объясняет

этот факт автор классификации так: «При

действии психогенных факторов,

адресующихся к «месту наименьшего

сопротивления», могут наступать

временные нарушения адаптации, отклонения

в поведении». При повзрослении ребенка

особенности его характера, проявившиеся

в детстве, остаются достаточно выраженными,

теряют свою остроту, но с возрастом

вновь могут проявиться отчетливо

(особенно если возникает заболевание).

Объясняет

этот факт автор классификации так: «При

действии психогенных факторов,

адресующихся к «месту наименьшего

сопротивления», могут наступать

временные нарушения адаптации, отклонения

в поведении». При повзрослении ребенка

особенности его характера, проявившиеся

в детстве, остаются достаточно выраженными,

теряют свою остроту, но с возрастом

вновь могут проявиться отчетливо

(особенно если возникает заболевание).

Классификация акцентуаций характеров у подростков, которую предложил А. Е. Личко, выглядит следующим образом:

Гипертимный

тип. Подростки этого

типа отличаются подвижностью,

общительностью, склонностью к озорству.

В происходящие вокруг события они всегда

вносят много шума, любят неспокойные

компании сверстников, при хороших общих

способностях они обнаруживают

неусидчивость, недостаточную

дисциплинированность, учатся неровно.

Настроение у них всегда хорошее,

приподнятое. С взрослыми, родителями,

педагогами у них нередко возникают

конфликты. Такие подростки имеют много

разнообразных увлечений, но эти увлечения,

как правило, поверхностны и быстро

проходят. Подростки гипертимного типа

зачастую переоценивают свои способности,

бывают слишком самоуверенными, стремятся

показать себя, прихвастнуть, произвести

на окружающих впечатление.

Такие подростки имеют много

разнообразных увлечений, но эти увлечения,

как правило, поверхностны и быстро

проходят. Подростки гипертимного типа

зачастую переоценивают свои способности,

бывают слишком самоуверенными, стремятся

показать себя, прихвастнуть, произвести

на окружающих впечатление.

Циклоидный тип. Он характеризуется повышенной раздражительностью и склонностью к апатии. Подростки данного типа предпочитают находиться дома одни вместо того, чтобы где-то быть со своими сверстниками. Они тяжело переживают даже незначительные неприятности, на замечания реагируют крайне раздражительно. Настроение у них периодически меняется от приподнятого до подавленного (отсюда название данного типа) с периодами примерно в две-три недели.

Лабильный

тип. Этот тип крайне

изменчив в настроении, причем оно

зачастую непредсказуемо. Поводы для

неожиданного изменения настроения

могут быть самые ничтожные, например,

кем-то случайно оброненное обидное

слово, чей-то неприветливый взгляд. Все

они “способны погрузиться в уныние и

мрачное расположение духа при отсутствии

каких-либо серьезных неприятностей и

неудач”. От сиюминутного настроения

этих подростков зависит многое в их

психологии и поведении. Соответственно

этому настроению настоящее и будущее

для них может расцвечиваться то радужными,

то мрачными красками. Такие подростки,

когда они находятся в подавленном

настроении, крайне нуждаются в помощи

и поддержке со стороны тех, кто мог бы

их настроение поправить, способен их

отвлечь, приободрить и развлечь.

Все

они “способны погрузиться в уныние и

мрачное расположение духа при отсутствии

каких-либо серьезных неприятностей и

неудач”. От сиюминутного настроения

этих подростков зависит многое в их

психологии и поведении. Соответственно

этому настроению настоящее и будущее

для них может расцвечиваться то радужными,

то мрачными красками. Такие подростки,

когда они находятся в подавленном

настроении, крайне нуждаются в помощи

и поддержке со стороны тех, кто мог бы

их настроение поправить, способен их

отвлечь, приободрить и развлечь.

Астеноневротический тип. Этот тип характеризуется повышенной мнительностью и капризностью, утомляемостью и раздражительностью. Особенно часто утомляемость проявляется при выполнении трудной умственной работы.

Сензитивный

тип. Ему свойственна

повышенная чувствительность ко всему:

к тому, что радует, и к тому, что огорчает

или пугает. Эти подростки не любят

больших компаний, слишком азартных,

подвижных, озорных игр. Они обычно

застенчивы и робки при посторонних

людях и поэтому часто производят

впечатление замкнутости. Открыты и

общительны они бывают только с теми,

кто им хорошо знаком, общению со

сверстниками предпочитают общение с

малышами и взрослыми. Они отличаются

послушанием и обнаруживают большую

привязанность к родителям. В юношеском

возрасте у таких подростков могут

возникать трудности адаптации к кругу

сверстников, а также “комплекс

неполноценности”. Вместе с тем у этих

же подростков довольно рано формируется

чувство долга, обнаруживаются высокие

моральные требования к себе и окружающим

людям. Недостатки в своих способностях

они часто компенсируют выбором сложных

видов деятельности и повышенным усердием.

Эти подростки разборчивы в нахождении

для себя друзей и приятелей, обнаруживают

большую привязанность в дружбе, обожают

друзей, которые старше их по возрасту.

Они обычно

застенчивы и робки при посторонних

людях и поэтому часто производят

впечатление замкнутости. Открыты и

общительны они бывают только с теми,

кто им хорошо знаком, общению со

сверстниками предпочитают общение с

малышами и взрослыми. Они отличаются

послушанием и обнаруживают большую

привязанность к родителям. В юношеском

возрасте у таких подростков могут

возникать трудности адаптации к кругу

сверстников, а также “комплекс

неполноценности”. Вместе с тем у этих

же подростков довольно рано формируется

чувство долга, обнаруживаются высокие

моральные требования к себе и окружающим

людям. Недостатки в своих способностях

они часто компенсируют выбором сложных

видов деятельности и повышенным усердием.

Эти подростки разборчивы в нахождении

для себя друзей и приятелей, обнаруживают

большую привязанность в дружбе, обожают

друзей, которые старше их по возрасту.

Психастенический

тип. Такие подростки

характеризуются ранним интеллектуальным

развитием, склонностью к размышлениям

и рассуждениям, к самоанализу и оценкам

поведения других людей. Такие подростки,

однако, нередко бывают больше сильны

на словах, чем в деле. Самоуверенность

у них сочетается с нерешительностью, а

безаппеляционность суждений — со

скоропалительными действиями,

предпринимаемых как раз в те моменты,

когда требуется осторожность и

осмотрительность.

Такие подростки,

однако, нередко бывают больше сильны

на словах, чем в деле. Самоуверенность

у них сочетается с нерешительностью, а

безаппеляционность суждений — со

скоропалительными действиями,

предпринимаемых как раз в те моменты,

когда требуется осторожность и

осмотрительность.

Шизоидный

тип. Его наиболее

существенной черта — замкнутость. Эти

подростки не очень тянутся к сверстникам,

предпочитают быть одни, находиться в

компании взрослых. “Душевное одиночество

даже не тяготит шизоидного подростка,

который живет в своем мире, своими

необычными для детей этого возраста

интересами”. Такие подростки нередко

демонстрируют внешнее безразличие к

другим людям, отсутствие к ним интереса.

Они плохо понимают состояния других

людей, их переживания, не умеют

сочувствовать. Их внутренний мир зачастую

наполнен различными фантазиями, особыми

увлечениями. Во внешнем проявлении

своих чувств они достаточно сдержаны,

не всегда понятны окружающим, прежде

всего для своих сверстников, которые

их, как правило, не очень любят.

Эпилептоидный тип. Эти подростки часто плачут, изводят окружающих, особенно в раннем детстве. “ Такие дети, — любят мучить животных, избивать и дразнить младших и слабых, издеваться над беспомощными и неспособными дать отпор. В детской компании они претендуют не просто на лидерство, а на роль властелина. Их типичные черты – жестокость, властность, себялюбие. В группе детей, которыми они управляют, такие подростки устанавливают свои жесткие, почти террористические порядки, причем их личная власть в таких группах держится в основном на добровольной покорности других детей или на страхе. В условиях жесткого дисциплинарного режима они чувствуют себя нередко на высоте, стараются угождать начальству, добиваться определенных преимуществ перед сверстниками, получить власть, установить диктат над окружающими.

Истероидный

тип. Главная черта этого

типа — эгоцентризм, жажда постоянного

внимания к своей особе. У подростков

данного типа выражена склонность к

театральности, позерству, рисовке. Такие

дети с трудом выносят, когда в их

присутствии хвалят их товарища, когда

другим уделяют больше внимания, чем им

самим. “Желание привлекать к себе взоры,

слушать восторги и похвалы становиться

для них насущной потребностью”. Для

таких подростков характерны претензии

на исключительное положение среди

сверстников, и чтобы оказать влияние

на окружающих, привлечь к себе внимание,

они часто выступают в группах в роли

зачинщиков и заводил. Вместе с тем,

будучи неспособными выступить как

настоящие лидеры и организаторы дела,

завоевать себе неформальный авторитет,

они часто и быстро терпят фиаско.

Такие

дети с трудом выносят, когда в их

присутствии хвалят их товарища, когда

другим уделяют больше внимания, чем им

самим. “Желание привлекать к себе взоры,

слушать восторги и похвалы становиться

для них насущной потребностью”. Для

таких подростков характерны претензии

на исключительное положение среди

сверстников, и чтобы оказать влияние

на окружающих, привлечь к себе внимание,

они часто выступают в группах в роли

зачинщиков и заводил. Вместе с тем,

будучи неспособными выступить как

настоящие лидеры и организаторы дела,

завоевать себе неформальный авторитет,

они часто и быстро терпят фиаско.

Неустойчивый тип. Его иногда неверно характеризуют как слабовольный, плывущий по течению. Подростки данного типа обнаруживают повышенную склонность и тягу к развлечениям, причем без разбора, а также к безделью и праздности. У них отсутствуют какие-либо серьезные, в том числе профессиональные интересы, они почти не думают о своем будущем.

Конформный

тип. Данный тип демонстрирует

бездумное, некритическое, а часто

конъюнктурное подчинение любым

авторитетам, большинству в группе. Такие

подростки обычно склонны к морализаторству

и консерватизму, а их главное жизненное

кредо — “быть, как все”. Это тип

приспособленца, который ради своих

собственных интересов готов предать

товарища, покинуть его в трудную минуту,

но, что бы он ни совершил, он всегда

найдет оправдание своему поступку,

причем нередко не одно.

Данный тип демонстрирует

бездумное, некритическое, а часто

конъюнктурное подчинение любым

авторитетам, большинству в группе. Такие

подростки обычно склонны к морализаторству

и консерватизму, а их главное жизненное

кредо — “быть, как все”. Это тип

приспособленца, который ради своих

собственных интересов готов предать

товарища, покинуть его в трудную минуту,

но, что бы он ни совершил, он всегда

найдет оправдание своему поступку,

причем нередко не одно.

Классификация А.Е. Личко построена на основе результатов наблюдений и их обобщения и по современным представлениям не является научно точной. Кроме того возникает вопрос, что делать с теми людьми, которые не вписываются в классификацию и не могут быть отнесены однозначно ни к одному из предложенных типов? Это довольно значительная часть – до половины всех людей.

«Понятие и структура правовой информации» (Материал подготовлен специалистами КонсультантПлюс) / КонсультантПлюс

ПОНЯТИЕ И СТРУКТУРА ПРАВОВОЙ ИНФОРМАЦИИ

(материалы подготовлены специалистами

АО «Консультант Плюс»)

КонсультантПлюс: примечание.

Условия и порядок вступления в силу федеральных нормативных правовых актов см. справочную информацию

Условия и порядок вступления в силу международных договоров Российской Федерации. Порядок их опубликования см. справочную информацию

В сфере юридической деятельности и правовой информатизации широко применяется термин «правовая информация». К правовой информации относятся, прежде всего, правовые акты, а также вся информация, которая связана с правом: материалы подготовки законопроектов и других нормативных правовых актов, их обсуждения и принятия, учета и упорядочения, толкования и реализации правовых норм, изучения практики их применения. В правовую информацию включаются также материалы о правовом образовании и разработке научных концепций развития права.

Исходя из сказанного, правовую информацию можно определить как массив правовых актов и тесно связанных с ними справочных, нормативно — технических и научных материалов, охватывающих все сферы правовой деятельности.

Правовую информацию, в зависимости от того, кто является ее «автором», то есть от кого она исходит, и на что направлена, можно разделить на три большие группы: официальная правовая информация, информация индивидуально — правового характера, имеющая юридическое значение, и неофициальная правовая информация.

Официальная правовая информация — это информация, исходящая от полномочных государственных органов, имеющая юридическое значение и направленная на регулирование общественных отношений.

Информация индивидуально — правового характера, имеющая юридическое значение, — это информация, исходящая от различных субъектов права, не имеющих властных полномочий, и направленная на создание (изменение, прекращение) конкретных правоотношений.

Неофициальная правовая информация — это материалы и сведения о законодательстве и практике его осуществления (применения), не влекущие правовых последствий и обеспечивающие эффективную реализацию правовых норм.

Рассмотрим названные группы более подробно.

Открыть полный текст документа

Боль в почках — основные причины, классификация характера боли, диагностика заболеваний почек

Акция! Скидка 20% на первичный прием врача для новых пациентов клиники по промокоду «ПЕРВЫЙ20».

Одна из самых распространенных жалоб на приеме врача-уролога — боль в почках. Однако точно определить беспокоящий орган можно только с помощью тщательной диагностики.

Одна из самых распространенных жалоб на приеме врача-уролога — боль в почках. Однако точно определить беспокоящий орган можно только с помощью тщательной диагностики. Приносить дискомфорт в области поясницы и по бокам нижней части спины могут не только сами почки, но и их ближайшие «соседи»: селезенка, печень, органы мочеполовой системы и брюшной полости, а также заболевания опорно-двигательного аппарата. Далеко не всем известно, что чаще всего почки «болят» в нижнем подреберье (они располагаются чуть выше поясницы).

Заболевания почек, вызывающие боли в поясничной области:

- пиелонефрит

Воспалительное бактериальное заболевание, которое чаще всего возникает у детей до 7-и лет, девушек от 18-и до 30-и лет, а также у пожилых мужчин. Оно сопровождается болями ноющего и тянущего характера, высокой температурой, головными болями. Развивается очень стремительно: первые симптомы становятся ощутимы уже через пару часов. - гломерулонефрит

Почки при заболевании поражаются сразу с двух сторон. Нарушается фильтрационная функция. Оно может быть вызвано аномалиями строения почек, инфекциями и токсикациями, а также онкологией. Человек испытывает сильные и режущие боли, повышение АД, сокращение мочеиспускания, недомогание, слабость, снижение аппетита, работоспособности. - почечная недостаточность

Серьезное заболевание, которое приводит к частичной или полной утрате способности почек образовывать мочу. Это может привести к поражению практически всех органов и систем организма. Данная патология возникает как следствие нарушения гемодинамики почек, сильной интоксикации или инфекции, острых периодов почечных заболеваний, травматических состояний. Основной симптом: резкое сокращение количества мочи. Если заболевание было зафиксировано на поздней стадии, назначается гемодиализ и подготовка к пересадке почки. - нефроптоз (смещение почки)

Причин возникновения патологии много: резкая потеря веса, травмы в области живота, аномальное развитие органа, состояния после беременности. Болевой симптом здесь очень сильный, его не удается устранить при помощи анальгезирующих средств. Боль в большинстве случаев усиливается при принятии вертикального положения, ближе ко второй половине дня. - злокачественные новообразования в почках (рак органа)

На ранней стадии заболевание обнаружить сложно, так как оно протекает бессимптомно. В развитии рак проявляется кровяными выделениями в моче, тупой постоянной болью в разных частях живота, скачками температуры, потерей веса. Для того, чтобы избежать проблему, необходимо регулярно проходить профилактические осмотры. - доброкачественные новообразования в почках (гамартомы, аденомы)

Течение на ранней стадии проходит бессимптомно. В развитии возникают тянущие боли и дискомфорт в области поясницы. Лечение осуществляется хирургическим вмешательством. - мочекаменная болезнь

При образовании камней человек испытывает очень сильные боли, так как при движении объект двигается и повреждает ткани. Данный вид боли называют почечной коликой. Она начинается приступообразно и может «выстрелить» в любой области поясницы, а также нижней части живота и паховой области. - почечные кисты

Патология возникает в зрелом возрасте, но также встречается ее врожденный или приобретенный вид. Большие кисты могут вызывать боль в поясничной области, появление крови в моче, повышение АД.

Определить причину болезненности в области почек без тщательного обследования невозможно. Не менее опасно пытаться лечить симптом самостоятельно.

Любая, даже незначительная патология почек может перерасти в глобальную проблему. Неправильное лечение или его отсутствие способствуют переходу заболевания в хроническую форму.

Нередко присоединяются инфекции, поражаются другие органы и системы.

Отсутствие надлежащей терапии может привести к развитию тяжелых патологий. Среди них наиболее распространенными считаются сердечная недостаточность, энцефалопатия, отек легких и головного мозга. В тяжелых случаях возможны развитие сепсиса, уремическая кома и смерть пациента.

Избежать осложнений и избавиться от болей в области почек довольно просто. Не откладывайте обращение в клинику. Выберите хорошего врача, который поможет выяснить причину дискомфорта и подобрать методы лечения. Приходите на прием к специалистам Кутузовского лечебно-диагностического центра. Мы поможем вам справиться с проблемой и избежать появления серьезных патологий.

Необходимо немедленно обратиться к врачу, если вы замечаете:

- вы чувствуете боли в поясничной области (как отдельно с каждой стороны, так и одновременно с двух сторон)

- дискомфорт в области верхней части поясницы в утренние часы

- боль в пояснице, сопровождающуюся ознобом и повышением температуры тела

- что количество мочеиспусканий, а также самой мочи резко снизились

- частое мочеиспускание небольшим количеством мочи

- изменение консистенции мочи (появление замутнения, крови, мелких камней и песка)

- дискомфорт при мочеиспускании (жжение, боли)

Для диагностики заболеваний почек может потребоваться немало исследований. Чаще всего больному человеку неудобно посещать разные медицинские центры в поисках такой возможности. Кутузовский лечебно-диагностический центр предоставляет своим пациентам возможность пройти полноценное обследование в одном месте. Вам не придется тратить время на ожидание или выстаивать длительные очереди. Все процедуры проводятся по предварительной записи в точно установленное время.

У нас есть все необходимое оборудование для проведения исследований любой сложности. Для диагностики применяются высокоточные приборы, что позволяет избежать ошибочных результатов и подобрать максимально эффективную схему лечения. Ваше здоровье и комфорт для нас приоритетны.

Приходите на прием в клинику, чтобы вернуть себе радость жизни без боли.

Для постановки точного диагноза врач-уролог может назначить следующие диагностические методы:

- лабораторные исследования (общий анализ крови и мочи; биохимическое исследование, бактериологические исследования)

- УЗИ почек

- КТ почек при подозрении на МКБ для исключения новообразований

Если вы хотите до приема к специалисту самостоятельно снизить интенсивность боли, вам может помочь соблюдение диеты: исключите из рациона соленую, острую и копченую пищу, пейте отвары лечебных трав. Держите тело, а в особенности область поясницы и ноги, в тепле, соблюдайте постельный режим.

Помните, что любое заболевание, выявленное на ранней стадии, легче поддается лечению и экономит ваши силы и средства. При появлении первых симптомов заболеваний почек при первой же возможности обратитесь к врачу-урологу или пройти одну из комплексных программ обследования.

В нашем центре вы можете записаться к хорошим специалистам:

Содержание данной статьи проверено и подтверждено на соответствие медицинским стандартам врачом-урологом Горовым Дмитрием Владиславовичем.

Цены

|

Название |

Цена |

|---|---|

| Прием (осмотр, консультация) врача-терапевта первичный | 2 200 ₽ |

| Прием (осмотр, консультация) врача-терапевта повторный | 1 900 ₽ |

Публикацию проверил:

|

№№ |

Наименование вида (типа) |

Код |

|

1 |

Транспортные происшествия, в т.ч. |

01 |

|

1.1. |

на железнодорожном транспорте |

01а |

|

1.2. |

на водном транспорте |

01б |

|

1.3. |

на воздушном транспорте |

01в |

|

1.4. |

на наземном транспорте |

01 г |

|

происшедшие: |

||

|

1.5. |

В пути на работу (с работы) на транспортном средстве работодателя (или сторонней организации на основании договора с работодателем) |

011 |

|

1.6. |

Во время служебных поездок (в т.ч. в пути следования в служебную командировку) на общественном транспорте |

012 |

|

1.7. |

Во время служебных поездок на личном транспортном средстве |

013 |

|

1.8. |

Во время пешеходного передвижения к месту работы |

014 |

|

2. |

Падение пострадавшего с высоты, в т.ч. |

02 |

|

2.1. |

Падение на ровной поверхности одного уровня, включая: |

021 |

|

2.1.1. |

Падение на скользкой поверхности, в том числе покрытой снегом или льдом |

0211 |

|

2.1.2. |

Падение на поверхности одного уровня в результате проскальзывания, ложного шага или спотыкания |

0212 |

|

2.2. |

Падение при разности уровней высот (с деревьев, мебели, со ступеней, приставных лестниц, строительных лесов, зданий, оборудования, транспортных средств и т.д.) и на глубину (в шахты, ямы, рытвины и др.) |

022 |

|

3. |

Падение, обрушение, обвалы предметов, материалов, земли и пр., в т.ч. |

03 |

|

3.1. |

Обрушение и осыпь земляных масс, скал, камней, снега и др. |

031 |

|

3.2. |

Обвалы зданий, стен, строительных лесов, лестниц, складированных товаров и др. |

032 |

|

3.3. |

Удары падающими предметами и деталями (включая их осколки и частицы) при работе (обращении) с ними |

033 |

|

3.4. |

Удары случайными падающими предметами |

034 |

|

4. |

Воздействие движущихся, разлетающихся, вращающихся предметов, деталей, машин и т.д., в т.ч. |

04 |

|

4.1. |

Контактные удары (ушибы) при столкновении с движущимися предметами, деталями и машинами (за исключением случаев падения предметов и деталей), в том числе в результате взрыва |

041 |

|

4.2. |

Контактные удары (ушибы) при столкновении с неподвижными предметами, деталями и машинами, в том числе в результате взрыва |

042 |

|

4.3. |

Защемление между неподвижными и движущимися предметами, деталями и машинами (или между ними) |

043 |

|

4.4. |

Защемление между движущимися предметами, деталями и машинами (за исключением летящих или падающих предметов, деталей и машин) |

044 |

|

4.5. |

Прочие контакты (столкновения) с предметами, деталями и машинами (за исключением ударов (ушибов) от падающих предметов) |

045 |

|

5. |

Попадание инородного тела |

05 |

|

5.1. |

Через естественные отверстия в организме |

051 |

|

5.2. |

Через кожу (край или обломок другого предмета, заноза и т.п.) |

052 |

|

5.3. |

Вдыхание и заглатывание пищи либо инородного предмета, приводящее к закупорке дыхательных путей |

053 |

|

6. |

Физические перегрузки и перенапряжения |

06 |

|

6.1. |

Чрезмерные физические усилия при подъеме предметов и деталей |

061 |

|

6.2. |

Чрезмерные физические усилия при толкании или демонтировании предметов и деталей |

062 |

|

6.3. |

Чрезмерные физические усилия при переноске или бросании предметов |

063 |

|

7. |

Воздействие электрического тока, в т.ч. |

07 |

|

7.1. |

Природного электричества (молнии) |

071 |

|

8. |

Воздействие излучений (ионизирующих и неионизирующих) |

08 |

|

9. |

Воздействие экстремальных температур и других природных факторов |

09 |

|

9.1. |

Воздействие повышенной температуры воздуха окружающей или рабочей среды |

091 |

|

9.2. |

Воздействие пониженной температуры воздуха окружающей или рабочей среды |

092 |

|

9.3. |

Соприкосновение с горячими и раскаленными частями оборудования, предметами или материалами, включая воздействие пара и горячей воды |

093 |

|

9.4. |

Соприкосновение с чрезмерно холодными частями оборудования, предметами и материалами |

094 |

|

9.5. |

Воздействие высокого или низкого атмосферного давления |

095 |

|

10. |

Воздействие дыма, огня и пламени |

10 |

|

10.1. |

Воздействие неконтролируемого огня (пожара) в здании или сооружении |

101 |

|

10.2. |

Воздействие неконтролируемого огня (пожара) вне здания или сооружения, в том числе пламени от костра |

102 |

|

10.3. |

Воздействие контролируемого огня в здании или сооружении (огня в печи, камине и т.д.) |

103 |

|

10.4. |

Повреждения при возгорании легковоспламеняющихся веществ и одежды |

104 |

|

11. |

Воздействие вредных веществ |

11 |

|

11.1. |

Воздействие вредных веществ путем вдыхания, попадания внутрь или абсорбции в результате неправильного их применения или обращения с ними |

111 |

|

11.2. |

Воздействие вредных веществ (в том числе алкоголя, наркотических, токсических или иных психотропных средств) в результате передозировки или злоупотребления при их использовании |

112 |

|

12. |

Повреждения в результате нервно-психологических нагрузок и временных лишений (длительное отсутствие пиши, воды и т.д.) |

12 |

|

13. |

Повреждения в результате контакта с растениями, животными, насекомыми и пресмыкающимися |

13 |

|

13.1. |

Укусы, удары и другие повреждения, нанесенные животными и пресмыкающимися |

131 |

|

13.2. |

Укусы и ужаливания ядовитых животных, насекомых и пресмыкающихся |

132 |

|

13.3. |

Повреждения в результате контакта с колючками и шипами колючих и ядовитых растений |

133 |

|

14. |

Утопление и погружение в воду, в т.ч. |

14 |

|

14.1. |

Во время нахождения в естественном или искусственном водоеме |

141 |

|

14.2. |

В результате падения в естественный или искусственный водоем |

142 |

|

15. |

Повреждения в результате противоправных действий других лиц |

15 |

|

16. |

Повреждения в результате преднамеренных действий по причинению вреда собственному здоровью (самоповреждения и самоубийства) |

16 |

|

17. |

Повреждения при чрезвычайных ситуациях природного, техногенного, криминогенного и иного характера, в т.ч. |

17 |

|

17.1. |

В результате землетрясений, извержений вулканов, снежных обвалов, оползней и подвижек грунта, шторма, наводнения и др. |

171 |

|

17.2. |

В результате аварий, взрывов и катастроф техногенного характера |

172 |

|

17.3. |

В результате взрывов и разрушений криминогенного характера |

173 |

|

17.4. |

При ликвидации последствий стихийных бедствий, катастроф и других чрезвычайных ситуаций природного, техногенного, криминогенного и иного характера |

174 |

|

18. |

Воздействие других неклассифицированных травмирующих факторов |

18 |

Классификация речевых нарушений

Нарушения речи как у взрослых, так и у детей могут быть следствием «неправильного формирования» тех, или иных компонентов психической функции в детском возрасте либо нарушением работы уже сформированной речевой системы вследствие патогенного воздействия на нервную систему человека в более зрелом возрасте.

В зависимости от времени возникновения дисфункции, ее характера и интенсивности изменяются симптомы и качество речевых нарушений. Ниже приведены две наиболее распространенные классификации речевых нарушений, используемые в отечественной системе здравоохранения и образования.

Психолого-педагогическая классификация

Далее приведем пример еще одной классификации речевых нарушений (психолого- педагогическую), разработанную для комплектации детских речевых групп на основании симптома нарушения речи:

Нарушение средств общения

- Фонетико-фонематическое недоразвитие речи (ФФНР)

- Общее недоразвитие речи (ОНР), алалия, афазия

Нарушение применения средств общения

Клинико-педагогическая классификация речевых нарушений

Нарушения устной речи

- Дислалия – нарушение звукопроизношения при сохранном слухе и интеллекте

- Ринолалия (носовая речь) — нарушения звукопроизношения и тембра голоса из-за анатомического дефекта периферического отдела речевого анализатора

- Дизартрия – нарушение звукопроизношения и просодической (интонация, мелодика, ритм, высота) стороны речи при недостаточной иннервации мышц, обеспечивающих речевую функцию

- Дисфония – нарушение голоса (воспаление голосовых связок – ларингиты)

- Заикание – нарушение темпа и ритма речи из-за судорог мышц речевого аппарата

- Алалия – отсутствие или недоразвитие речи из-за органического повреждения мозга до 3-х летнего возраста

- Афазия – отсутствие или распад речи в результате органического повреждения головного мозга после 3-х лет

- Тахилалия – патологически ускоренный темп речи, повтор и пропуск слогов при сохранных грамматическом, лексическом и фонетическом аспектах речи. В чистом виде встречается редко – чаще в составе других речевых нарушений

- Брадилалия – патологически медленный темп речи вследствие поражения головного мозга. Чаще встречается в составе других речевых нарушений

Нарушения письменной речи

- Дисграфия – расстройство письменной речи, проявляющееся в специфических часто повторяющихся ошибках

- Дислексия – недостаточность чтения. Ошибки восприятия букв

- Дизорфография – невозможность автоматического применения на практике правил языка

В приведенной выше классификации расстройства устной речи разграничены в соответствии с органическими нарушениями, являющимися причинами этих речевых расстройств. Данные диагнозы ранее традиционно выставлялись врачами (неврологами), а не логопедами и психологами, несмотря на частую недостаточную компетенцию врачей в диагностике речевых нарушений. В настоящее время ситуация меняется и появляется все больше медицинских учреждений, где подобный речевой диагноз выставляется непосредственно речевым специалистом – логопедом, нейропсихологом.

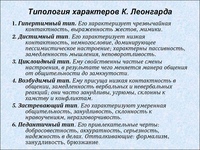

Классификация отклонений и акцентуаций характера

Стремление расширить исследование индивидуальностей человека порождает интерес к ее пограничным формам, промежуточным между нормой и патологией, т.е. к материалу психиатрии. Для описания этих форм существует два основных понятия – психопатии (П.Б.Ганнушкин) и акцентуации личности и характера (К.Леонгард, А.Е. Личко).

Психопатии – это аномалии характера, которые а) определяют весь психический облик человека, б) не подвергаются значительным изменениям при его жизни, в) мешают ему правильно адаптироваться в окружающей социальной среде. Акцентуации представляют собой крайние варианты нормы, при которых отдельные черты характера чрезмерно усилены (акцентуированы), вследствие чего человек болезненно уязвим по отношению к одним воздействиям, при относительной устойчивости – к другим.

Напомним, что отклонения и акцентуации характера рассматриваются психиатрами как резкие, обостренные проявления черт, присущих и нормальным людям. Поэтому не следует удивляться, если в описаниях психопатий кто-то узнает свои собственные черты, причем нередко не в одной, а сразу в нескольких различных группах.

Эмпирическое разделение психопатий на группы, так же как выделение типов акцентуаций, не имеет единого критерия. Главным из них остается содержательное сходство индивидуальных наборов черт с определенными психическими заболеваниями, не только циркулярным психозом или шизофренией, но и другими – паранойей, эпилепсией, истерией и т.д. Группы же циклоидов и шизоидов – сохраняются как отдельные, а иногда и как объединяющие несколько типовых отклонений. Рассмотрим кратко основные группы психопатий и типы акцентуаций, начиная с тех, которые близки к циклоидным и шизоидным (не повторяя, разумеется, описания последних). Заметим, что психопатические черты (по П.Б.Ганнушкину) характеризуют, прежде всего, взрослых людей, типы акцентуаций (по А.Е.Личко) – подростков, т.е. «переломный» возраст для становления характера и личности.

1. Конституционально-возбужденные (гипертимный тип) – люди, которые характеризуются постоянно приподнятыми, хорошим настроением, т.е. одним из двух крайних состояний циркулярного психоза. Жизнерадостные, общительные, приветливые, остроумные, они могут производить на окружающих самое благоприятное впечатление. Однако при резко выраженных формах симптоматика этой группы включает и характерные отрицательные черты. Стремление к лидерству (чаще – неформальному) делает конституционально-возбужденных заводилами шумных компаний, инициаторами масштабных начинаний, которые редко доводятся до конца. Энергичный гипертимный подросток обычно неусидчив, не систематичен в своих занятиях и обладает лишь поверхностными знаниями, интересами, при хороших способностях он, как правило, плохо успевает в школе, испытывая к тому же большие трудности при соблюдении дисциплинарных норм. В жизни конституционально-возбужденных возможны блестящие взлеты, хотя в деловых вопросах эти люди крайне ненадежны, и резкие падения, которые, впрочем, легко переносятся; гипертомики остаются находчивыми и изобретательными в любых затруднительных положениях. Их деятельная направленность может иметь, наконец, и асоциальные проявления (аферы, мошенничество и пр.).

2. Конституционально-депрессивные характеризуются вторым крайним состоянием циркулярного психоза – постоянно пониженным настроением, подавленностью, которые, как правило, определяют их общее самочувствие. Любая работа требует от них большого напряжения и поэтому быстро утомляет. Именно этих людей называют «тугодумами», несмотря на то, что их интеллектуальные возможности могут быть достаточно высокими. Трудности в общении у конституционально-депрессивных могут, с одной стороны, компенсироваться показным весельем на людях, а с другой – приводить к полной асоциальности, безразличию к окружающим. Показательным признаком данной группы психопатий являются постоянные самообвинения, чувство вины и собственной недостаточности, возникающее даже при незначительных проступках. В подростковом возрасте стабильных отклонений подобного рода обычно не выделяют, хотя по описаниям здесь достаточно близок им чувствительный, или сензитивный тип акцентуаций. Сензитивные подростки отличаются чрезмерной впечатлительностью, они пугливы, капризны (но беззлобны), до слез чувствительны к возможным насмешкам сверстников. В учебе старательны, но боятся любых проверок. Впрочем, подчас они стремятся изменить и даже сверхкомпенсировать свою «неполноценность», причем именно в тех сферах жизни (например, в общении), неудачи в которых переживаются ими особенно остро.

3. Лабильные (эмотивно-лабильные, реактивно-лабильные) отличаются изменчивостью настроения, его резкими перепадами по самым ничтожным поводам. Похвала и порицание, любые внешние события вызывают немедленные эмоциональные реакции, от чрезмерной радости до беспочвенного уныния. У них бывают «хорошие» и «плохие» дни, что нередко зависит от капризов погоды. Лабильных часто считают людьми легкомысленными, но это не так: они способны на глубокие постоянные чувства к родным, близким друзьям, любимому человеку.

Понятно, что к описанным типам примыкают и собственно циклоиды (в классификации П.Б.Ганнушкина все они объединяются в общую группу психопатий под данным названием). Шизоиды, как отдельная группа, определяются аутичностью в эмоциональной и познавательной сферах. Близкой к шизоидам по телесной конституции является группа астеников: речь идет об именно «психической астении», которую отличают два основных признака – раздражительность и утомляемость.

4. Неврастеники (астено-невротический тип) характеризуются чрезмерной возбудимостью, а также мнительностью в отношении своего здоровья. Частые болезненные ощущения соматических нарушений (сердца, органов пищеварения и др.) и повышенное внимание к ним отражают склонность к ипохондрии. Постоянные посетители врачебных кабинетов (подчас различных и сразу нескольких), неврастеники внушаемы и дают сильные психогенные реакции на любой возможный диагноз. Социальная дезадаптация неврастеников проявляется в смущении и робости, которые они могут пытаться скрыть под маской внешней развязности. Подростки астено-невротического типа обычно вспыльчивы, однако приступы бурной раздражительности быстро сменяются раскаянием. Часто они намеренно ищут собеседников, но в процессе общения – быстро устают.

5. Психастеники – другая разновидность астенической группы психопатий и отдельный тип акцентуаций (у подростков). Они отличаются чрезмерной нерешительностью, доходящей о полной неспособности принимать какие-либо решения. При этом длительное ожидание опасных событий в будущем (здоровье и участь близких, собственные неудачи и т.п.) травмируют их сильнее, чем события уже происшедшие. Постоянная тревога при необходимости выбора (даже в мелочах) компенсируется либо уходом в воображение, излишней мечтательностью и верой в приметы, либо – изобретением всякого рода ритуалов, выполнение которых «необходимо» для их осуществления. По тем же причинам психастеники часто склонны к самоанализу и рассуждениям, обстоятельным, но бесплодным.

6. Параноидная группа психопатий имеет своим главным признаком – склонность к образованию сверхценных идей. Особое (объективно неверное, завышенное) значение придает параноид собственной личности. Других людей он оценивает по отношению к своим высказываниям, мыслям, поступкам. Мышление параноидных психопатов характеризуется односторонностью, и понятное здесь резонерство (по сравнению, скажем, с шизоидами) не отличается богатством ассоциаций. В общении они недоверчивы, обидчивы, нередко мстительны и злопамятны. Неадекватны их реакции на успех: в житейских невзгодах (которые нередко возникают по собственной вине) они далеки от разочарования и остаются крайне некритичными к себе. Среди параноидов встречаются и фанатики (так их назвал П.Б.Ганнушкин), которые способны сделать конкретный вопрос (например, об определенной пищевой диете) едва ли не принципом мироздания и критерием моральных оценок. Интересно, что в подростковых типах акцентуаций характера аналог данного вида психопатий отсутствует.

7. Эпилептоидная группа психопатий (и соответствующий тип акцентуаций) характеризуется сочетанием трех основных признаков: а) крайней раздражительностью, вплоть до ярости; б) приступами аффективных расстройств (тоски, гнева, страха) и в) моральными дефектами (асоциальными установками). Впрочем, последняя особенность может быть скрытой и обнаруживаться, напротив, в преувеличенной гипер-социальности, в подчеркнуто строгом соблюдении моральных норм, доходящем до ханжества. Эпилептоиды обычно очень активны, напряженно деятельны, настойчивы и даже упрямы, в общении – эгоистичны, нетерпеливы и крайне нетерпимы к мнениям других, резко реагируя на любые возражения. Характерная для них страстность и любовь к сильным ощущениям нередко выражается в отсутствии чувства меры (в азартных играх, коллекционировании, обогащении и т.д.). Их мышление – инертно, вязко, нечувствительно к новому опыту. Эпилептоидные подростки отличаются аккуратностью, бережливостью, которая может переходить в жадность, ревность, требовательность при разделении как материальных благ, так и дружеского участия. В компаниях они стремятся к авторитарному лидерству, к власти, но если это не удается, жестокие к слабому, они заискивают перед сильными. Охотно упражняют свою физическую силу, тренируют ручные и др. навыки, предпочитая заниматься ими не в коллективе, а наедине и получая при этом особое чувственное удовольствие.

8. Истероиды (истероидный тип) отличаются, прежде всего, желанием обращать на себя постоянное внимание, для чего часто представляют себя и других намеренно неверно. Требующие признания, они любой ценой хотят казаться значительнее (как лучше, так и хуже), чем на самом деле. Это стремление выражается в эксцентричных поступках, оригинальных идеях, в рассказах о своих особых редко встречаемых (но объективно мнимых) заболеваниях, а также в демонстративных обмороках, припадках, попытках к суициду (как правило, «неудачных»). Их привязанности, интересы, чувства – поверхностны и во многом зависят от окружающих, так как рассчитаны на внешний эффект. Истероидные акцентуации часто встречаются у подростков, сопровождаясь инфантильностью и нередко смешиваясь с другими типами, например, гипертимным. Особую группу истероидов составляют (по П.Б. Ганнушкину) так называемые патологические лгуны, которые стремятся привлечь к себе внимание своей неумеренной фантазией.

9. Неустойчивые (неустойчивый тип) характеризуются полной реактивностью в поведении, которое целиком определяется внешней социальной средой. Не имея глубоких интересов и привязанностей, они скучают в одиночестве, но хорошо чувствуют себя в компаниях, умеют поддержать беседу. Неустойчивые легко внушаемы, в манере поведения часто берут пример с наиболее ярких своих приятелей. В работе они несамостоятельны, хотя и способны увлечься ею (но ненадолго), беспорядочны, неаккуратны и, наконец, ленивы. Неустойчивые особо склонны к приему наркотических и подобных им средств, под действием которых становятся, как правило, эгоистичными и жестокими, а по его окончании – горько раскаиваются, сетуя на случайные внешние обстоятельства. Слабоволие является основной чертой и неустойчивых подростков, оно делает их равнодушными к учебе, к любому, требующему усилий труду, к собственному будущему и требует постоянной, достаточно жесткой опеки.

10. Конституционально-глупые (конформный тип) – под этим названием сгруппированы психопатические индивиды с выраженной умственной недостаточностью. Однако это не единственный (а подчас и не главный) отличительный признак этой группы людей, которые, кстати, могут хорошо успевать в школе, средней и даже высшей, благодаря механическому запоминанию материала. Более точной является вторая ее характеристика – чрезмерная конформность, а именно – почти полное отсутствие собственной инициативы. Представители этой группы обычно ориентируются на свое непосредственное социальное окружение, однако не ищут в нем наиболее ярких примеров для подражания (как неустойчивые психопаты), но стремятся думать, действовать, «быть – как все». Неумение противостоять любому внешнему влиянию, внушаемость и консерватизм делают их ревностными слугами общепринятых мнений, дежурной моды и др., способными выражать банальные истины в напыщенной (нередко – усложненной) форме и с самым торжественным видом. Умелое и точное следование шаблону (например, модному фасону одежды или авторитетному, но, как правило, частному, лишенному констекста, предписанию) сопровождается ощущением собственной значительности, доходящим до горделивого самодовольства. Судьба подростков конформного типа определяется их средой, они могут становиться хорошими работниками (если их задания четко регламентированы), а попав в дурную компанию – втянуты в асоциальные действия из групповой «солидарности».

Терапевтическая работа с людьми, обладающими отклонениями или акцентуациями характера, направлена, прежде всего, на их социальную адаптацию. Основное значение приобретает, конечно, знание «уязвимых мест» этих людей. Такие «места», как мы видели, могут быть связаны с влиянием внешних условий или их внутренним тревожным ожиданием (мнительностью). К первым относится, например, отсутствие социальной поддержки со стороны ближайшего окружения (у сензитивов и конформных), ко второму -беспокойство о собственном здоровье (у неврастеников), в том числе – опасение «заразиться» (у эпилептоидов), или страх перед будущим – своим и своих близких (у психоастеников). Знание ситуаций, приводящим к болезненным расстройствам, позволяет моделировать благоприятные условия для нормальной жизни этих людей или их окружения. Так, если эти расстройства чисто реактивного характера, то нужно создать атмосферу доброжелательного, устойчивого социального отношения (для сензитивов и лабильных), допускающую смену основной деятельности (для гипертимиков), или, напротив, ее нормативную регламентацию (для неустойчивых). Если же отклонения и акцентуации характера имеют активные «природные» проявления (как, например, у параноидов и эпилептоидов), можно предупредить их нежелательные социальные последствия с помощью соответствующих фармакологических воздействий.

Завершая характеристику описательного подхода к анализу индивидуальности, можно выделить три его основные особенности.

Первая из них состоит в том, что реальность различных типов индивидуальности раскрывается перед исследователем (и понимается им) как непосредственная природная данность, существующая как бы «сама по себе». Не только потому, что она «живет» по своим законам, неизвестным эмпирику и независимым от него (хотя, быть может, именно поэтому индивидуальных типов характера достаточно много). Эта реальность представляется независимой от конкретного человека, которому дан тот или иной характер. Такие теоретические допущения имеют закономерные следствия в организации индивидуальной терапии. Терапевт (да и сам пациент) пытаются либо приспособиться к неподвластной им натуре, подбирая адекватные внешние условия, либо изменить ее, но также извне – путем внепсихических (например, фармакологических) влияний. Заметим, что при этом исследователь остается лишь участливым наблюдателем и выделяемые им эмпирические закономерности не имеют отношения к нему самому, и их последствия – происходят не с ним.

Вторая особенность касается представления о нормальной индивидуальности, т.е. о том, от чего отклоняется характер и с чем он сравнивается. В данном случае «норма» может быть получена путем статистического усреднения всех названных индивидуальных различий и является совершенно условным понятием. Действительно, поскольку совместить, найти промежуточный образец для столь многообразных индивидуальных отклонений, акцентуаций не представляется возможным, постольку так называемого «нормального характера» (по утверждению П.Б. Ганнушкина) просто не существует. Точнее, подобное усреднение и давало бы в результате – отсутствие характера, так как быть «бесхарактерным», значит не иметь никаких отличительных особенностей, что эмпирически – действительно пустая абстракция.

Третья особенность состоит в том, что в эмпирическую совокупность черт, составляющих ту или иную группу отклонений и акцентуаций, помещаются любые характеристики независимо от их функционального назначения и происхождения. Основные, базовые черты соседствуют здесь с различными своими модификациями, а их набор в целом разделяется, как правило, на черты первичные, т.е. врожденные, конституциональные, и вторичные, полученные при жизни. Полное же функциональное объяснение черт и их сочетаний (зачем и почему они складываются именно так), по существу, не входит в задачу исследователя, хотя и может иметь место в подходящих конкретных случаях.

Перечисленные особенности эмпирико-описательного, а по способу анализа – индуктивного подхода позволяют отличить его от подхода дедуктивного, направленного на выделение общих принципов построения типологии индивидуальностей. Не просто описать индивидуальные типы, но понять, объяснить необходимые закономерности их существования и, тем самым, раскрыть перед человеком возможность управления собственной индивидуальностью – такова общая цель этого подхода, к изложению которого мы и переходим. Понятно, что такая цель определяется радикально иными научно-теоретическими практическими установками

Вконтакте

Одноклассники

Похожие материалы в разделе Дифференциальная психология:

Классификация символов

Классификация символовКЛАССИФИКАЦИЯ ПЕРСОНАЖЕЙ

Общие группы символов I-XII считаются классами символов, которые включают в себя несколько типов символов, каждый из которых определен. Состояния каждого символа расположены в порядке важности и определены в Разделе B этой главы. Такое расположение состояний символов по символам и упорядочение или ранжирование типов символов в классе символов является попыткой сделать эту классификацию сравнительной и точной.См. Главу 5 для основных определений персонажей и типов персонажей, а также типов доказательств.

-

I. ПОЛОЖЕНИЕ И РАСПОЛОЖЕНИЕ (Класс символов с типами символов 1-8, как указано ниже. Состояния каждого типа символов описаны в Разделе B I этой главы).- Расположение. Положение органов или частей по отношению к окружающей среде (см. Раздел B I A, где описаны состояния персонажей этого типа).

- Позиция. Расположение или прикрепление органов или частей по отношению к другим, непохожим органам или основным частям (см. Раздел B I B).

- Расположение. Расположение органов или частей по отношению друг к другу (см. Раздел B I C).

- Ориентация. Расхождение органов или частей относительно центральной оси или точки (см. Раздел B I D).

- Поперечная осанка. Отношение концов одного органа или части к его центральной или поперечной оси (см. Раздел B I E).

- Продольная поза. Отношение краев одного органа или части к его центральной продольной оси (см. Раздел B I F).

- Общее структурное положение. Точка, точка, локальная или общая область или на одной структуре; например, апикальная часть листа, центральная точка лепестка (см. Раздел B I G).

- Эмбриональная позиция. Положение и расположение незрелых органов или частей.

- Праздник или префлорация. Расположение, в строгом смысле I 3, зародышевых частей цветка. Примечание: ростки чашечки и венчика в бутоне могут быть одинаковыми или разными (см. Раздел B I H).

- Ptyxis. Скручивание и складывание зародышевых листьев относительно центральной точки, поперечной оси или продольной оси; сочетание поперечной и продольной позы для эмбриональных частей (см. Раздел B I H).

- Вернация. Расположение зародышевых листьев в строгом смысле I 3. Большинство авторов так трактуют птиксис.

II. НОМЕР И РАЗМЕР- Номер. Любое значение или диапазон значений, выражающий абсолютное количество, сумму или совокупность отдельных единиц; или выражение относительных или сравнительных единиц (см. Раздел B II A).

- Размер. Пространственные размеры или пропорции любого органа или его частей, обычно выражаемые в виде числовых значений, относящихся к длине, ширине и глубине; или выражение относительных или сравнительных сумм (см. Раздел B II B).

- Циклический. Абсолютное количество оборотов частей, например количество оборотов цветочных частей или листьев (см. Раздел B II C).

- Merosity. Абсолютное количество частей внутри оборота, такое как количество лепестков в венчике или количество тычинок в андроциальном обороте (см. Раздел B II D).

- Fusion. Слияние или объединение подобных или непохожих органов или частей (см. Раздел B II E).

- Дивизия. Разделение, расхождение или разветвление на сегменты, части, доли и ветви любого органа или его частей (см. Раздел B II F).

III. ФОРМА И КОНТРОЛЬ- Форма. План определенной формы, плоский или двухмерный; или конкретная трехмерная фигура (см. Раздел B III A).

- Вершина.Кончик двумерной структуры, которая обычно ограничена верхними 5-10% полей; или верх трехмерной конструкции (см. Раздел B III B).

- Маржа. Граничная область стороны двумерной или плоской конструкции (см. Раздел B III C).

- База. Нижняя часть двумерной структуры, которая обычно ограничена нижними 5-10% полей; или дно трехмерной конструкции (см. Раздел B III B).

IV.ПОВЕРХНОСТЬ, ВЕНАЦИЯ, ТЕКСТУРА- Конфигурация. Рисунок на поверхности обычно является результатом внутренней структурной формы, за исключением жилкования (см. Раздел B IV A).

- Жилкование. Расположение жил, видимое на поверхности (см. Раздел B IV B). Особенности внутреннего жилкования см. В разделе «Жилкование» в главе 7.

- Поверхность. Особенности, происходящие из эпидермальных выростов или наростов, за исключением типов покровных трихом (см. Раздел B IV C).

- Одежда или украшения.Типы покрытия трихом (см. Раздел B IV D). Для получения информации об отдельных типах трихом см. Трихомы в главе 7.

- Текстура. Характерное физическое состояние или консистенция органа или его частей (см. Раздел B IV E).

В. СЕКС- Цветок. Половое состояние отдельного цветка (см. Раздел B V A).

- Соцветие. Расположение цветов в соцветии по половому признаку; или полное разнообразие половых условий цветка в соцветии (см. Раздел B V B).

- Завод. Общее разнообразие половых условий цветка в пределах одного растения (см. Раздел B V C).

- Население или вид. Общее разнообразие половых условий цветков в популяции (см. Раздел B V C).

VI. ОПЫЛЕНИЕ И УДОБРЕНИЕ- Тип опыления. Агент, с помощью которого пыльца переносится из пыльцевого мешка или пыльника на рыльце или семяпочку (см. Раздел B VI A).

- Путь опыления.Структурный путь, который проходит пыльцевая трубка, достигая семяпочки (см. Раздел B VI B).

- Тип удобрения. Источник (и) мужских гамет для оплодотворения (см. Раздел B VI C).

- Путь оплодотворения. Структурный путь, по которому пыльцевая трубка проходит к зародышевому мешку после достижения семяпочки (см. Раздел B VI D).

VII. ВРЕМЕННЫЕ ЯВЛЕНИЯ- Периодичность. Повторяемость явлений роста через определенные промежутки времени; или сезонность возникновения явлений роста растений (см. Раздел B VII A).

- Созревание. Относительное время развития различных органов или частей растений (см. Раздел B VII B).

- Продолжительность. Продолжительность существования завода или любой из его составных частей (см. Раздел B VII C).

VIII. РОСТ И РАЗВИТИЕ- Область роста. Расположение меристематической области на или внутри органа или его частей (см. Раздел B VIII A).

- Периодичность роста. Повторение или продолжительность меристематической активности в органе или его частях (см. Раздел B VIII B).

- Общие разработки. Направление созревания внутри растения его органов или его частей; например, от основания вверх или изнутри наружу (см. Раздел B VIII C).

- Типы развивающих побегов. Происхождение и созревание разных побегов (стебель с листьями) (см. Раздел B VIII D).

IX. УЗОРЫ- Симметрия. Соответствие частей по размеру, форме и расположению на противоположных сторонах плоскости, линии или точки (см. Раздел B IX A).

- Системы размещения. Общее расположение органов относительно друг друга, основанное на угле расхождения между следующими друг за другом схожими частями (см. Раздел B IX B).

- Паттерны ветвления. Положение ответвлений на главной оси и расположение боковых ответвлений (см. Раздел B IX C).

X. СЕКРЕТОРИЯ И ИЗБИРАТЕЛЬНЫЕ СТРУКТУРЫ- Функциональные типы. Химическая природа выделяемого или выделяемого вещества (см. Раздел B X A).

- Позиционные типы. Расположение желез на органах или частях (см. Раздел B X B).

XI. ЦВЕТ- Стандарт. Определение цвета на основе принятых цветовых таблиц и кодов (см. Раздел B XI A).

- Распределение. Образцы пестрого цвета на органе или частях (см. Раздел B XI B).

XII. ОБЩЕЕ- Общие. Дескрипторы, применимые к любому персонажу.

Классификация символов — Real Python

В этом уроке вы изучите строковых метода , которые классифицируют строку на основе символов , которые она содержит.Вот методы классификации персонажей:

-

str.isalnum () -

str.isalpha () -

str.isdigit () -

str.isidentifier ()* -

- ключевое слово (*) -

ул. Печатная () -

ул. Пробел () -

str.istitle () -

ул. Нижняя () -

ул. Верхняя () -

ул.isascii ()*

Метод .isidentifier () определяет, является ли целевая строка допустимым идентификатором. Что такое идентификатор Python ? Идентификатор — это имя, используемое для определения переменной, функции, класса или какого-либо другого типа объекта.

Идентификаторы Python:

- Должен начинаться с буквенного символа или символа подчеркивания (

_) - Может быть одним символом

- Может сопровождаться любым буквенно-цифровым символом или знаком подчеркивания

- Не может быть других знаков пунктуации

Еще одна потенциальная ловушка, на которую следует обратить внимание при именовании собственных идентификаторов, заключается в том, что вы не можете использовать существующее ключевое слово Python .Чтобы проверить, является ли имя, которое вы собираетесь использовать, существующим ключевым словом, вы можете импортировать функцию под названием iskeyword () из модуля под названием keyword :

>>> from keyword import iskeyword

>>> iskeyword ('и')

Правда

Вот ключевые слова Python:

| Ключевые слова Python | |||||

|---|---|---|---|---|---|

Ложь | перерыв | остальное | если | не | в то время как |

Истинно | класс | кроме | импорт | или | с |

Нет | продолжить | наконец | дюйм | проход | доход |

и | деф | для | это | поднять | по всему миру |

as | del | из | лямбда | возврат | нелокальный |

assert | Элиф | попробовать |

Дополнительную информацию о модулях Python см. На странице

Модули и пакеты Python — Введение.Метод .isascii () был представлен в Python 3.7.

Вот как использовать str.isalnum () :

>>> s = 'abc123'

>>> s.isalnum ()

Правда

>>> '' .isalnum ()

Ложь

>>> s = 'abc $ 123'

>>> s.isalnum ()

Ложь

Вот как использовать str.isalpha () :

>>> s = 'ABCabc'

>>> s.isalpha ()

Правда

>>> s = 'ABC123'

>>> с.isalpha ()

Ложь

Вот как использовать str.isdigit () :

>>> s = '123456'

>>> s.isdigit ()

Правда

>>> s = '123abc'

>>> s.isdigit ()

Ложь

Вот как использовать str.isidentifier () :

>>> 'spam32'.isidentifier ()

Правда

>>> '32spam'.isidentifier ()

Ложь

>>> 'foo $ 32'.isidentifier ()

Ложь

>>> 'def'.identifier ()

Правда

Вот как использовать iskeyword () :

>>> from keyword import iskeyword

>>> 'def'.isidentifier ()

Правда

>>> 'def'.iskeyword ()

Отслеживание (последний вызов последний):

Файл "", строка 1, в

'def'.iskeyword ()

AttributeError: объект 'str' не имеет атрибута 'iskeyword'

>>> iskeyword ('def')

Правда

>>> iskeyword ('и')

Правда

>>> iskeyword ('spam32')

Ложь

Вот как использовать str.isprintable () :

>>> s = 'a \ tb'

>>> s.isprintable ()

Ложь

>>> s = 'a b'

>>> с.isprintable ()

Правда

>>> s = ''

>>> s.isprintable ()

Правда

>>> s = 'а \ п б'

>>> s.isprintable ()

Ложь

Вот как использовать str.isspace () :

>>> s = 'a \ n b'

>>> s.isspace ()

Ложь

>>> s = '\ t \ n'

>>> s.isspace ()

Правда

Вот как использовать str.istitle () :

>>> s = 'И восходит солнце'

>>> с.istitle ()

Правда

>>> s = "Бургеры Боба!"

>>> s.istitle ()

Ложь

Вот как использовать str.islower () :

>>> s = 'asdlkjgadb'

>>> s.islower ()

Правда

>>> s = "spamIsgood"

>>> s.islower ()

Ложь

Вот как использовать str.isupper () :

>>> s = 'SPAMBACON'

>>> s.isupper ()

Правда

>>> s = "СПАМБЕКОН №1!"

>>> с.isupper ()

Правда

Вот как использовать str.isascii () :

>>> s = 'ABCabc # $%'

>>> s.isascii ()

Правда

>>> '' .isascii ()

Правда

>>> '' .isascii ()

Правда

>>> '∑'.isascii ()

Ложь

Классификация символов | Документы Microsoft

- 2 минуты на чтение

В этой статье

Каждая из этих подпрограмм проверяет указанный однобайтовый символ, широкий символ или многобайтовый символ на соответствие условию.(По определению набор символов ASCII от 0 до 127 является подмножеством всех наборов многобайтовых символов. Например, японская катакана включает символы ASCII, а также символы, отличные от ASCII.)

На условия тестирования влияет параметр LC_CTYPE категории параметра локали; см. setlocale для получения дополнительной информации. Версии этих функций без суффикса _l используют текущий языковой стандарт для этого зависящего от языкового стандарта поведения; версии с суффиксом _l идентичны, за исключением того, что вместо этого они используют переданный параметр локали.

Обычно эти процедуры выполняются быстрее, чем тесты, которые вы могли бы написать, и им следует отдавать предпочтение. Например, следующий код выполняется медленнее, чем вызов isalpha (c) :

if ((c> = 'A') && (c <= 'Z')) || ((c> = 'a') && (c <= 'z'))

вернуть ИСТИНА;

Процедуры классификации персонажей

| Обычный | Условие проверки символов |

|---|---|

| isalnum, iswalnum, _isalnum_l, _iswalnum_l, _ismbcalnum, _ismbcalnum_l, _ismbcalpha, _ismbcalpha_l, _ismbcdigit, _ismbcdigit_l | Буквенно-цифровой |

| _ismbcalnum, _ismbcalnum_l, _ismbcalpha, _ismbcalpha_l, _ismbcdigit, _ismbcdigit_l | Многобайтный буквенно-цифровой |

| isalpha, iswalpha, _isalpha_l, _iswalpha_l, _ismbcalnum, _ismbcalnum_l, _ismbcalpha, _ismbcalpha_l, _ismbcdigit, _ismbcdigit_l | По алфавиту |

| isascii, __isascii, iswascii | ASCII |

| isblank, iswblank, _isblank_l, _iswblank_l, _ismbcsblank, _ismbcsblank_l | Пробел (пробел или горизонтальная табуляция) |

| iscntrl, iswcntrl, _iscntrl_l, _iswcntrl_l | Контроль |

| iscsym, iscsymf, __iscsym, __iswcsym, __iscsymf, __iswcsymf, _iscsym_l, _iswcsym_l, _iscsymf_l, _iswcsymf_l | Буква, подчеркивание или цифра |

| iscsym, iscsymf, __iscsym, __iswcsym, __iscsymf, __iswcsymf, _iscsym_l, _iswcsym_l, _iscsymf_l, _iswcsymf_l | Буква или подчеркивание |

| isdigit, iswdigit, _isdigit_l, _iswdigit_l, _ismbcalnum, _ismbcalnum_l, _ismbcalpha, _ismbcalpha_l, _ismbcdigit, _ismbcdigit_l | Десятичная цифра |

| isgraph, iswgraph, _isgraph_l, _iswgraph_l, _ismbcgraph, _ismbcgraph_l, _ismbcprint, _ismbcprint_l, _ismbcpunct, _ismbcpunct_l, _ismbcblank, _ismbcblank_l, _ismbcspace, _ismbcspace | Для печати кроме места |

| islower, iswlower, _islower_l, _iswlower_l, _ismbclower, _ismbclower_l, _ismbcupper, _ismbcupper_l | Строчные |

| _ismbchira, _ismbchira_l, _ismbckata, _ismbckata_l | Хирагана |

| _ismbchira, _ismbchira_l, _ismbckata, _ismbckata_l | Катакана |

| _ismbclegal, _ismbclegal_l, _ismbcsymbol, _ismbcsymbol_l | Допустимый многобайтовый символ |

| _ismbcl0, _ismbcl0_l, _ismbcl1, _ismbcl1_l, _ismbcl2, _ismbcl2_l | Многобайтовый символ уровня Японии 0 |

| _ismbcl0, _ismbcl0_l, _ismbcl1, _ismbcl1_l, _ismbcl2, _ismbcl2_l | Многобайтовый символ уровня Японии 1 |

| _ismbcl0, _ismbcl0_l, _ismbcl1, _ismbcl1_l, _ismbcl2, _ismbcl2_l | Многобайтовый символ уровня Японии 2 |

| _ismbclegal, _ismbclegal_l, _ismbcsymbol, _ismbcsymbol_l | Неалфавитно-цифровой многобайтный символ |

| isprint, iswprint, _isprint_l, _iswprint_l, _ismbcgraph, _ismbcgraph_l, _ismbcprint, _ismbcprint_l, _ismbcpunct, _ismbcpunct_l, _ismbcblank, _ismbcblank_l, _ismbcspace, _ismbcspace | Для печати |

| ispunct, iswpunct, _ispunct_l, _iswpunct_l, _ismbcgraph, _ismbcgraph_l, _ismbcprint, _ismbcprint_l, _ismbcpunct, _ismbcpunct_l, _ismbcblank_space, _ismbcpunct_l, _ismbcblank_space, _ismbcpace | Пунктуация |

| isspace, iswspace, _isspace_l, _iswspace_l, _ismbcgraph, _ismbcgraph_l, _ismbcprint, _ismbcprint_l, _ismbcpunct, _ismbcpunct_l, _ismbcblank, _ismbcblank_l, _ismbcspace, _ismbcspace | Белое пространство |

| isupper, iswupper, _ismbclower, _ismbclower_l, _ismbcupper, _ismbcupper_l | Заглавные |

| _isctype, iswctype, _isctype_l, _iswctype_l | Свойство, заданное параметром desc argument |

| isxdigit, iswxdigit, _isxdigit_l, _iswxdigit_l | Шестнадцатеричная цифра |

| _mbclen, mblen, _mblen_l | Возвращает длину допустимого многобайтового символа; результат зависит от установки категории LC_CTYPE текущей локали |

См. Также

Универсальные подпрограммы выполнения C по категориям

Как разработать CNN для классификации рукописных цифр MNIST

Последнее обновление 24 августа 2020 г.

Как разработать сверточную нейронную сеть с нуля для классификации рукописных цифр MNIST.

Задача классификации рукописных цифр MNIST - это стандартный набор данных, используемый в компьютерном зрении и глубоком обучении.

Хотя набор данных эффективно решен, его можно использовать в качестве основы для обучения и практики разработки, оценки и использования сверточных нейронных сетей с глубоким обучением для классификации изображений с нуля. Это включает в себя то, как разработать надежную систему тестирования для оценки производительности модели, как изучить улучшения модели и как сохранить модель, а затем загрузить ее, чтобы делать прогнозы на новых данных.

В этом руководстве вы узнаете, как с нуля разработать сверточную нейронную сеть для классификации рукописных цифр.

После прохождения этого руководства вы будете знать:

- Как разработать тестовую программу для разработки надежной оценки модели и установления базового уровня производительности для задачи классификации.

- Как изучить расширения базовой модели для улучшения обучения и возможностей модели.

- Как разработать окончательную модель, оценить производительность окончательной модели и использовать ее для прогнозирования новых изображений.

Начните свой проект с моей новой книги «Глубокое обучение для компьютерного зрения», включающей пошаговых руководств и файлов исходного кода Python для всех примеров.

Приступим.

- Обновлено декабрь 2019 г. : обновленные примеры для TensorFlow 2.0 и Keras 2.3.

- Обновлено январь 2020 г. : исправлена ошибка, из-за которой модели определялись вне цикла перекрестной проверки.

Как разработать сверточную нейронную сеть с нуля для классификации рукописных цифр MNIST

Фотография Ричарда Аллавея, некоторые права защищены.

Обзор учебного пособия

Это руководство разделено на пять частей; их:

- Набор данных классификации рукописных цифр MNIST

- Методология оценки модели

- Как разработать базовую модель

- Как разработать улучшенную модель

- Как завершить модель и сделать прогнозы

Хотите результатов с помощью глубокого обучения для компьютерного зрения?

Пройдите мой бесплатный 7-дневный ускоренный курс электронной почты (с образцом кода).

Нажмите, чтобы зарегистрироваться, а также получите бесплатную электронную версию курса в формате PDF.

Нажмите здесь, чтобы подписаться

Среда разработки

В этом руководстве предполагается, что вы используете автономные Keras, работающие поверх TensorFlow с Python 3. Если вам нужна помощь в настройке среды разработки, см. Этот учебник:

Набор данных классификации рукописных цифр MNIST

Набор данных MNIST - это аббревиатура, обозначающая модифицированный набор данных Национального института стандартов и технологий.

Это набор данных из 60000 небольших квадратных изображений размером 28 × 28 пикселей в оттенках серого, состоящих из рукописных одиночных цифр от 0 до 9.

Задача состоит в том, чтобы отнести данное изображение рукописной цифры к одному из 10 классов, представляющих целые числа от 0 до 9 включительно.

Это широко используемый и хорошо изученный набор данных, по большей части это « решено, ». Самые эффективные модели - это сверточные нейронные сети с глубоким обучением, которые достигают точности классификации выше 99% с коэффициентом ошибок от 0.4% и 0,2% в тестовом наборе данных.

В приведенном ниже примере загружается набор данных MNIST с помощью API Keras и создается график первых девяти изображений в наборе обучающих данных.