6. Характеристика непроизвольного, произвольного и послепроизвольного внимания

Внимание – состояние психологической концентрации, сосредоточенности на каком – либо объекте. Это процесс сознательного или бессознательного (полусознательного) отбора одной информации, поступающей через органы чувств, и игнорирование другой.

Непроизвольное

внимание – это внимание, которое включается,

функционирует, переключается с объекта

на объект и отключается автоматически,

без

участия сознания и воли человека.

Его вызывают

раздражители,

соответствующие потребностям индивида,

значимые для него.

Оно связано и с общей направленностью

личности. Непроизвольное внимание

возникает независимо от сознательных

намерений субъекта, без каких – либо

волевых усилий с его стороны. Основная

функция НВ заключается в быстрой и

правильной

ориентации

в постоянно меняющихся условиях среды,

в выделении тех его объектов, которые

могут иметь в данный момент наибольший

жизненный смысл.

Произвольное внимание – это внимание, которое, напротив, регулируется волей человека, находится под его сознательным контролем. Оно возникает, если в деятельности человек ставит перед собой определенную задачу и сознательно вырабатывает программу действий. В ПВ проявляется активность личности, при этом внимании интересы носят опосредованный характер (это интересы цели, результата деятельности). Основной функцией ПВ является активное регулирование протекания психических процессов. Именно благодаря наличию ПВ человек способен активно, избирательно «извлекать» из памяти нужные ему сведения, выделять главное, существенное, принимать правильные решения, осуществлять задачи, возникающие в деятельности.

Послепроизвольное

внимание. Это

понятие было введено Н.Ф.Добрыниным. Если в

целенаправленной деятельности для

личности интересными и значимыми

становятся содержание и сам процесс

деятельности, а не только его результат,

как при произвольном сосредоточении,

то говорят о послепроизвольном внимании. Деятельность так захватывает в этом

случае человека, что ему не требуется

заметных волевых усилий для поддержания

внимания. Послепроизвольное внимание,

появляясь

вслед за произвольным,

не может быть сведено к нему. Так как

это внимание связано с сознательно

поставленной целью, оно не может быть

сведено и к непроизвольному вниманию.

Послепроизвольное внимание характеризуется

длительной

высокой сосредоточенностью,

с ним обоснованно связывают наиболее

интенсивную и плодотворную умственную

деятельность.

Деятельность так захватывает в этом

случае человека, что ему не требуется

заметных волевых усилий для поддержания

внимания. Послепроизвольное внимание,

появляясь

вслед за произвольным,

не может быть сведено к нему. Так как

это внимание связано с сознательно

поставленной целью, оно не может быть

сведено и к непроизвольному вниманию.

Послепроизвольное внимание характеризуется

длительной

высокой сосредоточенностью,

с ним обоснованно связывают наиболее

интенсивную и плодотворную умственную

деятельность.

свойства внимания:

Устойчивость

— проявляется в способности в течение

длительного времени сохранять состояние

внимания,

на каком – либо объекте, предмете

деятельности, не отвлекаясь и не ослабляя

внимание. Устойчивость внимания может

определяться различными причинами.

Одни из них связаны с индивидуальными

физиологическими особенностями человека,

в частности со свойствами его нервной

системы, общим состоянием организма в

данный момент времени; другие характеризуют

психические состояния (возбужденность,

заторможенность), третьи соотносятся

с мотивацией (наличием или отсутствием

интереса к предмету деятельности, его

значимостью для личности) четвертые –

с внешними обстоятельствами осуществления

деятельности.

Люди со слабой нервной системой или перевозбужденные могут быстро утомляться, становиться импульсивными. Человек, который не очень хорошо чувствует себя физически, как правило, характеризуется неустойчивым вниманием. Отсутствие интереса к предмету способствует частому отвлечению внимания от него, и, напротив, наличие интереса сохраняет внимание в повышенном состоянии в течение длительного времени. Если отсутствуют внешне отвлекающие моменты, внимание бывает достаточно устойчивым.

Сосредоточенность – проявляется в различиях, которые имеются в степени концентрированности внимания на одних объектах и его отвлечение от других.

Распределение

– оно

состоит в способности рассредоточить

внимание на значительном пространстве,

параллельно выполнять несколько видов

деятельности или совершать несколько

различных действий. Известно, что память

на прерванные действия способна

сохраняться в течение определенного

времени. В течение этого периода человек

может без труда возвратиться к продолжению

прерванной деятельности.

Объем внимания – определяет количество информации, одновременно способной сохраняться в сфере повышенного внимания человека. Численная характеристика среднего объема внимания людей 5-7 единиц информации. Она обычно устанавливается посредством опыта, в ходе которого человеку на очень короткое время предъявляется большое количество информации. То, что он за это время успевает заметить, и характеризует его объем внимания. Основным условием расширения объема внимания является формирование умений группировать, систематизировать, объединять по смыслу воспринимаемый материал.

Переключаемость

– понимается

как перевод

внимания с одного объекта на другой, с

одного вида деятельности на иной. Данная характеристика человеческого

внимания проявляется в скорости, с

которой он может переводить свое внимание

с одного объекта на другой, причем такой

перевод может быть как не произвольным,

так и произвольным. В первом случае

индивид невольно переводит свое внимание

на что-либо такое, что его случайно

заинтересовало, а во втором – сознательно,

усилием воли заставляет себя сосредоточиться

на каком-нибудь, даже не очень интересном

объекте. Переключаемость внимания, если

она происходит на непроизвольной основе,

может свидетельствовать о его

неустойчивости, но такую неустойчивость

не всегда есть основание рассматривать

как отрицательное качество. Она нередко

способствует временному отдыху организма,

анализатора, сохранению и восстановлению

работоспособности нервной системы и

организма в целом.

Данная характеристика человеческого

внимания проявляется в скорости, с

которой он может переводить свое внимание

с одного объекта на другой, причем такой

перевод может быть как не произвольным,

так и произвольным. В первом случае

индивид невольно переводит свое внимание

на что-либо такое, что его случайно

заинтересовало, а во втором – сознательно,

усилием воли заставляет себя сосредоточиться

на каком-нибудь, даже не очень интересном

объекте. Переключаемость внимания, если

она происходит на непроизвольной основе,

может свидетельствовать о его

неустойчивости, но такую неустойчивость

не всегда есть основание рассматривать

как отрицательное качество. Она нередко

способствует временному отдыху организма,

анализатора, сохранению и восстановлению

работоспособности нервной системы и

организма в целом.

С переключаемостью

внимания функционально связаны два

разнонаправленных процесса: включение

и отвлечение внимания. Первый

характеризуется тем, как человек

переключает внимание на нечто и полностью

сосредотачивается на нем; второй – тем,

как осуществляется процесс отвлечения

внимания.

Особенности и условия формирования внимания ребенка раннего, дошкольного и школьного возрастов.

Историю развития внимания пытался проследить Л.С. Выготский в русле своей культурно – исторической концепции. Он писал, что история внимания ребенка есть история развития организованности его поведения, что ключ к генетическому пониманию внимания следует искать не внутри, а вне личности ребенка.

Произвольное

внимание возникает из того, что окружающие

ребенка люди « начинают при помощи ряда

стимулов и средств направлять внимание

ребенка, руководить его вниманием,

подчинять его своей власти и тем самым

дают в руки ребенка те средства, с помощью

которых он впоследствии и сам овладевает

своим вниманием.» Культурное развитие

внимания заключается в том, что при

помощи взрослого ребенок усваивает ряд

искусственных стимулов – средств

(знаков),

посредством которых он дальше направляет

свое собственное поведение и внимание.

Процесс возрастного развития внимания

по идеям Выготского Л.

Различия в характеристиках произвольного и непроизвольного внимания возрастают, начиная с дошкольного возраста, и достигают максимума в школьном возрасте, а затем вновь обнаруживают тенденцию к уравниванию.

Л.С.

Выготский пишет, что с самых первых дней

жизни ребенка развитие его внимания

происходит в среде, включающий так

называемый двойной ряд стимулов,

вызывающих внимание. Первый ряд – это

сами окружающие предметы, которые своими

яркими необычными свойствами приковывают

внимание ребенка. С другой стороны, это

речь взрослого человека, произносимые

им слова, которые первоначально выступают

в роли стимулов – указаний, направляющих

непроизвольное внимание ребенка. Таким

образом, с первых дней жизни ребенка

его внимание в значительной его части

оказывается

направляемым с помощью слов – стимулов.

С другой стороны, это

речь взрослого человека, произносимые

им слова, которые первоначально выступают

в роли стимулов – указаний, направляющих

непроизвольное внимание ребенка. Таким

образом, с первых дней жизни ребенка

его внимание в значительной его части

оказывается

направляемым с помощью слов – стимулов.

Вместе с постепенным овладением активной речью ребенок начинает управлять и первичным процессом собственного внимания, причем сначала – в отношении других людей, ориентируя их собственное внимание обращенным к ним словом в нужную сторону, а затем — и в отношении самого себя.

Общая

последовательность культурного развития

внимания по Л.С.Выготскому состоит в

следующем: «Сначала люди действуют по

отношению к ребенку, затем он сам вступает

во взаимодействие с окружающими, наконец,

он начинает действовать на других и

только в конце начинает действовать на

себя » Вначале

взрослый направляет его внимание словами

на окружающие его вещи и вырабатывает,

таким образом, из слов могущественные

стимулы – указания; затем ребенок

начинает активно участвовать в этом

указании и сам начинает пользоваться

словом и звуком как средством указания,

т. е. обращать внимание взрослых на

интересующий его предмет.

е. обращать внимание взрослых на

интересующий его предмет.

Слово,

которым пользуется взрослый, обращаясь

к ребенку, появляется первоначально в

роли указателя, выделяющего для ребенка

те или иные признаки в предмете,

обращающего его внимание на эти признаки.

При обучении слово все более направляется

в сторону выделения абстрактных отношений

и приводит к образованию абстрактных

понятий. Л.С.Выготский считал, что

управление языка как средства направления

внимания и указателя к образованию

представлений имеет для педагогики

огромное значение, поскольку с помощью

слов ребенок выходит в сферу межличностного

отношения, где открывается простор для

личностного развития. Первоначально

процессы произвольного внимания,

направляемого речью взрослого, являются

для ребенка скорее процессами его

внешнего дисциплинирования, чем

саморегуляции. Постепенно, употребляя

то же самое средство овладения вниманием

отношению к самому себе, ребенок переходит

к самоуправлению поведением, т.е. к

произвольному вниманию.

Этапы развития детского внимания:

Первые недели – месяцы жизни. Появление ориентировочного рефлекса как объективного, врожденного признака непроизвольного внимания ребенка.

Конец первого года жизни. Возникновение ориентировочно – исследовательской деятельности как средства будущего развития произвольного внимания.

Начало второго года жизни. Обнаружение зачатков произвольного внимания под влиянием речевых инструкций взрослого, направление взора на названный взрослым предмет.

Второй – третий год жизни. Достаточно хорошее развитие указанной выше первоначальной формы произвольного внимания.

Четыре с половиной – пять лет. Появление способности направлять внимание под влиянием сложной инструкции взрослого.

Пять – шесть лет. Возникновение элементарной формы произвольной внимания под влиянием самоинструкции (с опорой на внешние вспомогательные средства).

Школьный возраст.

Дальнейшее развитие и

совершенствование произвольного

внимания, включая волевое.

Дальнейшее развитие и

совершенствование произвольного

внимания, включая волевое.

Теоретическая концепция внимания П.Я.Гальперина. Основные положения:

Внимание является одним из моментов ориентировочно – исследовательской деятельности. Оно представляет собой психологическое действие, направленное на содержание образа, мысли, другого феномена, имеющегося в данный момент времени в психике человека.

По своей функции внимание представляет собой контроль за этим содержанием. В каждом действии человека есть ориентировочная, исполнительская и контрольная части. Эта последняя и представляется вниманием как таковым.

В отличие от других действий, которые производят определенный продукт, деятельность контроля, или внимание, не имеет отдельного, особенного результата.

Внимание как самостоятельный, конкретный акт выделяется лишь тогда, когда действие становится не только умственным, но и сокращенным.

Не всякий контроль стоит

рассматривать как внимание. Контроль

лишь оценивает действие, в то время как

внимание способствует его улучшению.

Не всякий контроль стоит

рассматривать как внимание. Контроль

лишь оценивает действие, в то время как

внимание способствует его улучшению.Во внимании контроль осуществляется при помощи критерия, меры, образа, что создает возможность сравнения результатов действия и его уточнения.

Произвольное внимание есть планомерно осуществляемое внимание, т.е. форма контроля, выполняемого по заранее составленному плану, образцу.

Для того чтобы сформировать новый прием произвольного внимания, мы должны наряду с основной деятельностью предложить человеку задание проверить ее ход и результаты, разработать и реализовать соответствующий план.

Все известные акты внимания, выполняющие функцию контроля как произвольного, так и непроизвольного, являются результатом формирования новых умственных действий.

Методы исследования внимания

Исследование

внимания имеет большое значение в работе

школьных психологов, в частности при

анализе причин неуспеваемости и при

выработке индивидуальных

психолого-педагогических мероприятий.

При исследовании внимания следует учитывать, что качества внимания у одного и того же человека зависят от многих факторов: возможны колебания внимания в зависимости от утомления и общего состояния организма, отношения человека к тому или иному виду деятельности, его эмоционального состояния. С другой стороны, внимание всегда «включено» в самые разнообразные психические явления, при его исследовании существует необходимость вычленения, «извлечения» его из этих процессов. Большинство разработанных проб на испытание внимания имеют варианты, позволяющие не только выявлять, но и количественно выражать различные свойства внимания: объем, переключаемость, устойчивость, концентрацию, избирательность и другие.

Объем

внимания. Все методы для изучения объема

внимания можно подразделить на прямые

и косвенные. Прямой метод предусматривает

предъявление материала (например, слов,

букв, изображений предметов) в короткие

промежутки времени с помощью тахистоскопа

с последующим подсчетом замеченного

испытуемым. Индивидуальные оценки

результатов сравниваются со

среднегрупповыми.

Индивидуальные оценки

результатов сравниваются со

среднегрупповыми.

Расстройства внимания выявляются как во время беседы (отвлекается на посторонние раздражители, не может сосредоточиться, быстро утомляется, не может переключиться и т.д.), так и в ходе специального психодиагностического исследования. Из методик исследования внимания наиболее известны и широко применяются: корректурные пробы, счет по Крепелину, отыскивание чисел по таблицам Шульте, поочередное сложение, поочередное вычитание, тест Мюнстерберга и др.

Общая психопатология | Обучение | РОП

В норме внимание помогает индивиду воспринимать наиболее важные для него стимулы, игнорируя неважные, кроме того, внимание дает индивиду способность произвольно направлять и удерживать фокус своего внимания на интересующих его объектах, что позволяет продуктивно решать стоящие перед ним задачи.

Нарушения внимания могут быть достаточно разнообразными. Выделяют нарушения внимания, связанные с изменением состояния бодрствования (в этих случаях может быть нарушено, как произвольное, так и непроизвольное внимание), и нарушения характеристик произвольного внимания (его селективности, устойчивости, переключаемости, объема и пр. ).

).

Невнимание (апрозексия) — этот термин часто применятся сразу по отношению ко всей группе нарушений внимания, однако при более дифференцированном подходе его правильно использовать лишь в случаях общего угнетения процессов внимания, т.е. при отсутствии или затруднении фокусировки внимания как на важных, так и на неважных стимулах; в связи с этим восприятие всех стимулов нарушено, они игнорируются. В основе лежит снижение тонуса нервной системы, уровня бодрствования и готовности действовать. В таких состояниях человек выглядит вялым, недостаточно реагирующим на происходящее вокруг, его внимание трудно или невозможно чем-либо привлечь. Невнимание в той или иной степени выраженности наблюдается при угнетении сознания, интоксикациях седативными веществами, выраженном утомлении, апатии, грубых нарушениях интеллекта, органических поражениях головного мозга определенных локализаций. Например, при оглушении пациент воспринимает лишь малую часть окружающих его стимулов, он вял, аспонтанен, врачу приходится многократно повторять свой вопрос, чтобы пациент мог сфокусировать свое внимание на нем и на попытках на него ответить. Врач из-за чрезмерного утомления и сонливости, например во время ночного дежурства, может упустить признаки болезни у своего пациента, в том числе как важные, так и неважные, допустить ошибку в своих действиях. Водитель в состоянии алкогольного опьянения или под действием седативных препаратов из-за невнимательности может «просмотреть» изменение ситуации на дороге.

Врач из-за чрезмерного утомления и сонливости, например во время ночного дежурства, может упустить признаки болезни у своего пациента, в том числе как важные, так и неважные, допустить ошибку в своих действиях. Водитель в состоянии алкогольного опьянения или под действием седативных препаратов из-за невнимательности может «просмотреть» изменение ситуации на дороге.

Сверхотвлекаемость (гиперметаморфоз, сверхбодрствование) — фокусировка внимания сразу на всех действующих на человека стимулах, как на важных, так и на неважных. В основе — состояние, противоположное невниманию, — повышенная активация нервной системы и «чрезмерный» уровень бодрствования. В результате внимание становится крайне неустойчивым, сверхизменчивым, человек постоянно отвлекается на каждый новый стимул. В выраженных случаях нарушаются последовательность, цельность мыслительной деятельности, вплоть до развития состояния растерянности, недоумения. Наблюдается при маниакальных состояниях, интоксикациях стимуляторами и психодислептиками, иногда при галлюцинаторно-бредовых состояниях, органических поражениях головного мозга определенных локализаций.

Неустойчивость внимания (патологическая отвлекаемость) — неспособность человека удерживать фокус произвольного внимания на нужном ему объекте, в связи с чем страдает продуктивность его деятельности. При слабости произвольного внимания ведущую роль начинает занимать внимание непроизвольное, из-за этого человек постоянно отвлекается на посторонние стимулы, случайно попадающие в поле его внимания, случайные мысли («витает в облаках», «считает ворон»). Выраженность расстройства может в значительной степени варьировать.

Синдром дефицита внимания с гиперактивностью (СДВГ), основу которого составляет неустойчивость произвольного внимания, может проявляться целым спектром относительно негрубых нарушений внимания, отражающихся преимущественно на успеваемости в школе и работоспособности. Необходимо учитывать, что способность к удержанию фокуса произвольного внимания постепенно формируется у ребенка по мере его развития, поэтому для оценки этого нарушения у детей нужно принимать во внимание возрастные нормы.

При некоторых случаях органических поражений головного мозга (особенно дорсальной поверхности лобных долей) неустойчивость внимания может достигать такой степени, что она полностью дезорганизует деятельность взрослого человека.

Больной К. 35 лет несколько лет назад перенес тяжелую травму головного мозга во время погрузочных работ в порту, последние годы находится в психиатрической больнице. В отделении, если кто-то из медсестер громко вызывает любого из пациентов, К. тут же откликается, бросает свои дела и бежит к этой медсестре через весь коридор. Таким же образом встречает каждого, кто входит в отделение, начинает бойко и громко с ним разговаривать, но потом также быстро отходит, обратив внимание на что-то новое. Полноценно побеседовать с лечащим врачом он не в состоянии — ответив на один-два вопроса, он переключается на случайные темы, сам начинает задавать вопросы, а если рядом что-то происходит, теряет всякое внимание к беседе с врачом и, не завершив беседу, уходит в интересующем его направлении, например, посмотреть, как стригут других больных или что принесла процедурная медсестра из аптеки.

Истощаемость внимания — неспособность человека длительное время удерживать фокус произвольного внимания; первоначально внимание направлено на нужный индивиду объект, но по мере утомления оно все более истощается, а следовательно, непроизвольное внимание выходит на первый план. Является достаточно характерным признаком утомления и астении. Например, студент, утомленный недосыпанием на ночных дежурствах, садится заниматься: какое-то время он сосредоточенно читает учебник, но через несколько страниц замечает, что думает о чем-то постороннем, пытается вспомнить, что он только что читал, но не может. В специальных психологических тестах истощаемость внимания проявляется увеличением количества ошибок в монотонном задании по ходу его выполнения. Истощаемость внимания также наблюдается при синдроме дефицита внимания с гиперактивностью, органическом поражении головного мозга.

Тугоподвижность внимания (вязкость, патологическая прикованность) — трудности с переключением внимания с одной темы или объекта на другую тему или объект. Рассматривается как проявление замедленного мышления, или брадифрении. Отмечается при органических заболеваниях головного мозга, в том числе эпилепсии, сосудистых заболеваниях и пр.

Рассматривается как проявление замедленного мышления, или брадифрении. Отмечается при органических заболеваниях головного мозга, в том числе эпилепсии, сосудистых заболеваниях и пр.

Про чрезмерную прикованность внимания к той или иной теме, от которой человек не может отвлечься и которая заслоняет для него все происходящее вокруг, говорят также, когда описывают патологические суждения (бред, сверхценные идеи и навязчивые явления).

Сужение объема внимания — возможность одновременно удержать в фокусе внимания лишь небольшое количество объектов. Достаточно яркий пример — аффекты (аффективно суженное сознание) — остро развивающееся состояние, когда на фоне сильного эмоционального волнения, происходит резкое ограничение объема воспринимаемой информации (в том числе так называемое туннельное зрение) с сохранением фокуса внимания только на эмоционально значимых объектах; другие объекты, окружающие человека (в том числе те, которые помогли бы найти выход из сложившейся ситуации или дали бы возможность альтернативному пути действий), не воспринимаются (подробнее см. аффекты, аффективно-шоковые реакции).

аффекты, аффективно-шоковые реакции).

В случаях, когда у человека всегда отмечается некоторый недостаток объема и распределения внимания, проявляющиеся в виде невозможности удерживать в фокусе внимания необходимое для выполнения той или иной деятельности количество информации, эти нарушения в настоящее время часто трактуют, как недостаточность объема рабочей памяти. Существует целый ряд подходов к тренингу рабочей памяти, для повышения когнитивной эффективности, включая компьютеризированные варианты, доступные для мобильных устройств (н., n-back test).

избирательность и переключение. Что такое внимание. Виды внимания

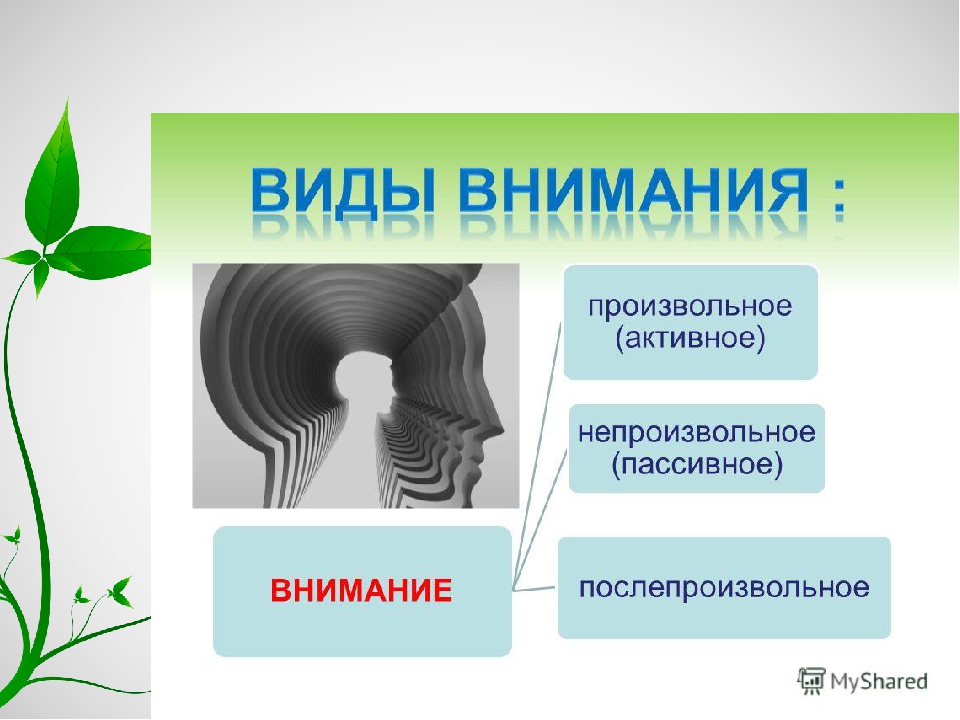

По активности человека в организации внимания различают три вида внимания: непроизвольное, произвольное и послепроизвольное.

Непроизвольное внимание – это сосредоточение сознания на объекте в силу его особенности как раздражителя.

Более сильный раздражитель на фоне действующих привлекает внимание человека. Вызывает непроизвольное внимание новизна раздражителя, начало и прекращение действия раздражителя.

Перечисленные особенности раздражителя ненадолго превращают его в объект внимания. Длительное сосредоточение непроизвольного внимания на предмете связано с потребностями в нем, с его значимостью для личности.

Предметы, создающие в процессе познания яркий эмоциональный тон, вызывают непроизвольное сосредоточение внимания. Еще большее значение для возникновения непроизвольного внимания имеют интеллектуальные, эстетические и моральные чувства.

Интерес выступает одной из важнейших причин длительного непроизвольного внимания к предметам.

В процессе познания интересным для человека является не то, что вовсе неизвестно, и не то, о чем уже все известно. Новое в известном вызывает познавательный интерес.

Произвольное внимание – это сознательно регулируемое сосредоточение на объекте, направляемое требованиями деятельности.

При произвольном внимании сосредоточение происходит не только на том, что эмоционально приятно, а в большей мере на том, что должно делать. Поэтому психологическое содержание произвольного внимания связано с постановкой цели деятельности и волевым усилием.

Поэтому психологическое содержание произвольного внимания связано с постановкой цели деятельности и волевым усилием.

Произвольное сосредоточение на объекте предполагает волевое усилие, которое и поддерживает внимание. Волевое усилие переживается как напряжение, мобилизация сил на решение поставленной цели. Оно помогает удерживать внимание на объекте, не отвлекаться, не ошибаться в действиях.

Произвольное внимание как свойство личности не может быть сформировано независимо от самой личности.

В послепроизвольном внимании снижается волевое напряжение, необходимое при сосредоточении в произвольном внимании. После-произвольное внимание – сосредоточение на объекте в силу его ценности для личности.

Послепроизвольное внимание возникает на основе интереса, но это не заинтересованность, стимулированная особенностями предмета, а проявление направленности личности. При таком внимании сама деятельность переживается как потребность, а ее результат личностно значим.

Переход к контролю деятельности на уровне послепроизвольного внимания в значительной степени определяется особенностями личности. Если произвольное внимание перешло в послепроизвольное, то до наступления общей усталости не чувствуется напряжения.

Вниманием называют способность человека выделять те или иные объекты из множества других и реагировать на них.

Виды и отличия

Существует несколько типологий внимания. Одна из основных делит его на следующие виды:

- Непроизвольное – с возникновением без усилия со стороны человека, вызванное свойствами самого объекта. Непроизвольное внимание (НВ) присуще как людям, так и животным, и является природным качеством. Оно является результатом так называемого ориентировочного рефлекса: комплексной реакции организма на новизну раздражителя. Со временем, по мере того, как раздражитель раз за разом воздействует на сознание, реакция притупляется. Однако, информация, полученная в контакте с раздражителем, запоминается сама собой, без усилия со стороны человека.

Непроизвольное внимание возникает в силу неожиданности появления раздражителя, его силы, новизны, контраста с окружающей средой, а также состояния психики и эмоций самого наблюдателя.

Непроизвольное внимание возникает в силу неожиданности появления раздражителя, его силы, новизны, контраста с окружающей средой, а также состояния психики и эмоций самого наблюдателя. - Произвольное – в отличие от непроизвольного, оно не присуще животным и является прерогативой человека. Оно всегда связано с волевым усилием и целенаправленной мыслительной деятельностью наблюдателя. Произвольное внимание (ПВ) одновременно является условием и результатом труда и общественной деятельности. С одной стороны, последовательная, целенаправленная работа невозможна без произвольного внимания. С другой стороны, его развитие происходит именно в результате осознанных действий, требующих умственных усилий и сосредоточенности.

- Постпроизвольное – естественное продолжение произвольного внимания, если деятельность является не только необходимой, но и вызывает интерес исполнителя. В таком случае волевого усилия для выполнения тех или иных действий уже не требуется: человек увлечен и способен без труда сконцентрироваться на работе.

Презентация: «Внимание»

Эти постоянно сменяют друг друга в процессе мыслительной деятельности. Так, человек может начать читать книгу в качестве справочного пособия для дальнейшей работы, а затем увлечься темой и продолжить чтение для собственного интереса и удовольствия.

Это яркий пример того, как постпроизвольное внимание приходит на смену произвольному. Если же человек утомится и потеряет концентрацию, ПВ может смениться непроизвольным – по отношению к посторонним объектам.

Чаще всего, впрочем, степень нашей концентрации не является слишком высокой, и произвольное и непроизвольное внимание успешно сочетаются друг с другом. Обдумывая решение задачи, мы успеваем проводить взглядом пролетающую за окном птицу, услышать телефонный звонок или почти механически ответить на посторонний вопрос коллеги.

Как повысить эффективность своих действий

При помощи произвольного внимания из множества объектов и явлений осознанно выделяются связанные с актуальной работой. По сути, ПВ предусматривает следующую последовательность действий: выбор и формулировка цели, организация и сосредоточение на ней, и, в конце концов, ее осуществление.

По сути, ПВ предусматривает следующую последовательность действий: выбор и формулировка цели, организация и сосредоточение на ней, и, в конце концов, ее осуществление.

Однако продолжительное удержание фокусировки на одном объекте или виде работы приводит к утомлению и упадку сил. В среднем, сосредоточенное умственное усилие человека начинает терять свою эффективность через 20 минут.

Презентация: «Свойства внимания»

Продолжение работы без перерыва вызывает усталость и неспособность к активному мыслительному процессу. Снижается произвольное и его замещает непроизвольный вид внимания.

Существует несколько факторов, помогающих повысить эффективность работы и не потерять концентрацию:

- Интерес к занятию, который позволяет произвольному вниманию перейти в постпроизвольное. В таком случае утомляемость существенно снижается, человек способен обработать больший объем информации с лучшими результатами.

- Привычные условия труда.

Как показывает практика, изменения в интерьере, освещении или звукоизоляции (в любую сторону) отвлекают и не дают сосредоточиться. Сохранение концентрации при этом требует больших, чем обычно, усилий, человек быстрее утомляется, и выполняемая им работа сильно теряет в качестве.

Как показывает практика, изменения в интерьере, освещении или звукоизоляции (в любую сторону) отвлекают и не дают сосредоточиться. Сохранение концентрации при этом требует больших, чем обычно, усилий, человек быстрее утомляется, и выполняемая им работа сильно теряет в качестве. - Отсутствие сильных раздражителей. К ним можно отнести резкие неожиданные шумы, вспышки света, обилие движущихся предметов вокруг, разговоры на посторонние темы. Все это также является отвлекающими факторами и мешает концентрации.

Следует, однако, заметить, что слабые раздражители – например, привычное тиканье часов, тихая музыка, приглушенные уличные звуки – наоборот способствуют сохранению внимания. Они ведут к возникновению слабых очагов возбуждения в коре головного мозга, которые дополняют собой основной очаг, связанный с выполнением текущей задачи; в результате сосредоточенность исполнителя и эффективность его работы возрастают. Таким образом НВ помогает укреплению ПВ.

Презентация: «Познавательные процессы человека»

Для сохранения приемлемого уровня концентрации рекомендуется регулярная смена деятельности.

У каждого человека есть свои особенности восприятия и переработки информации, склонности к тому или иному виду деятельности, но, если говорить об интеллектуальных усилиях, взрослому человеку в среднем достаточно делать перерывы приблизительно раз в час или полтора, переключаясь на более легкое или интересное задание, или физический труд, не требующий серьезной мыслительной нагрузки.

При таком графике работы мы, с одной стороны, не даем себе переутомляться, а с другой – с достаточным напряжением тренируем свою способность к концентрации.

Прочие свойства внимания

Помимо концентрации, у внимания есть и другие свойства – например, объем: количество объектов или занятий, которые мы можем воспринимать в один момент времени, а также распределение внимания – способность одновременно решать несколько задач. Объем и распределение внимания являются характеристиками, важными для выполнения различных действий в реальной жизни: ведь большинство ситуаций предполагает нашу способность к многозадачности.

Например, человек за рулем автомобиля должен одновременно следить за движением, дорожной разметкой и знаками, маневрами других автомобилистов. Дирижер оркестра читает партитуру и тут же отдает команды оркестрантам. Студент слушает лекцию, конспектирует и запоминает нужную информацию. При этом наше непроизвольное внимание отвлекает от выполнения основных действий на посторонние явления.

Занятия с детьми

Произвольное внимание развивается в процессе обучения с раннего детства, тогда как непроизвольное внимание является врожденным качеством. В отличие от непроизвольного, ПВ у детей нуждается в специальной тренировке, например, при помощи специальных занятий в дошкольных учреждениях и дома.

Такими занятиями могут быть упражнения на концентрацию: складывание картинок из нескольких частей, нахождение взаимосвязи между предметами, игра в слова и другие задачи, предполагающие интеллектуальное усилие.

Чем выше интерес ребенка к занятиям, тем эффективнее обучение.

Таким образом, одной из основных задач воспитателя является возбуждение детского интереса и привлечение всех видов внимания в помощь учебному процессу.

Важно учитывать, что для детей, как и для взрослых, существует порог, после которого сосредоточенность неизбежно снижается; упражнения теряют свой смысл и эффективность, а уставший ребенок становится сверх возбудимым и невосприимчивым к учебе. В таком случае бессмысленно настаивать на продолжении занятий: поможет переключение на другие занятия или игры, физические нагрузки или простая прогулка на свежем воздухе. Как и любой навык, требует постепенности, регулярных повторений и системного подхода.

Страница 4

Произвольное внимание

Характеризуя внимание человека, наряду с непроизвольным вниманием выделяют высшую специфически человеческую его форму – произвольное внимание. Этот вид внимания существенно отличается от непроизвольного внимания как по характеру происхождения, так и по способах осуществления.

Произвольное внимание возникает тогда, когда человек ставит перед собой определенные задачи, сознательные цели, что и обусловливает выделение отдельных предметов (воздействий) как объектов внимания. Приняв решение, поставив перед собой задачу заняться чем-то, какой-нибудь деятельностью (конспектировать книгу, слушать лекцию), мы, выполняя это решение, произвольно направляем и сосредотачиваем сознание на то, чем считаем нужным заняться. Направленность и концентрация внимания здесь зависит не от особенностей самих предметов, а от поставленной, намеченной задачи, цели. В этих условиях, когда внимание направлено на раздражители, не являющиеся не наиболее сильными, ни наиболее новыми или наиболее занимательными, нередко требуется определенное усилие воли, необходимое как для того, чтобы сохранить объект сосредоточения, т.е. не отвлекаться, так и для того, чтобы поддерживать определенную интенсивность процесса сосредоточения. Это особенно ярко проявляется при наличии в окружающей обстановке посторонних, иррелевантных и вместе с тем новых, сильных, представляющих большой интерес раздражителей, когда приходится сосредотачиваться как бы вопреки их воздействию. Таким образом, произвольное внимание есть проявление волн. Подчеркивая эту особенность произвольного внимания, его иногда называют волевым вниманием.

Таким образом, произвольное внимание есть проявление волн. Подчеркивая эту особенность произвольного внимания, его иногда называют волевым вниманием.

Произвольное внимание, как все высшие произвольные психические процессы, процесс опосредствованный, представляющий собой продукт социального развития. Это положение было особенно отчетливо подчеркнуто Л.С. Выготским.

Произвольное внимание первоначально опосредствовано общением ребенка со взрослыми. Указания, приказ взрослых, в виде речевой инструкции выделяют из окружающих ребенка предметов определенную, названную взрослым вещь, те самым избирательно направляют внимание ребенка и подчиняют его поведение задачам, связанным с деятельностью с этой вещью. При этом ребенку приходится обращать внимание на требуемые приказом (инструкцией) вещи или их признаки, отвлекаясь о своих непосредственных влечений. Постепенно по мере развития ребенок начинает строить свое поведение на основе собственных приказов, путем самостоятельной постановки задач. Сначала самоприказы даются во внешней развернутой речевой форме. Это и определяет избирательное выделение ребенком из окружающих предметов тех, которые становятся объектами его внимания. На первых этапах становления произвольного внимания необходимым условием его поддержания является наличие внешних опор – в виде развернутых практических действий с выделенными объектами и развернутой речи ребенка. В ходе дальнейшего развития произвольного внимания постепенно происходит сокращение внешних опор, они как бы врастают внутрь, превращаются во внутреннюю речевую инструкцию, вол внутреннее умственное действие, на основе которого осуществляется контроль и регуляция поведения, поддержание стойкой избирательной направленности сознания.

Сначала самоприказы даются во внешней развернутой речевой форме. Это и определяет избирательное выделение ребенком из окружающих предметов тех, которые становятся объектами его внимания. На первых этапах становления произвольного внимания необходимым условием его поддержания является наличие внешних опор – в виде развернутых практических действий с выделенными объектами и развернутой речи ребенка. В ходе дальнейшего развития произвольного внимания постепенно происходит сокращение внешних опор, они как бы врастают внутрь, превращаются во внутреннюю речевую инструкцию, вол внутреннее умственное действие, на основе которого осуществляется контроль и регуляция поведения, поддержание стойкой избирательной направленности сознания.

В произвольном внимании, таким образом, как и в других высших формах психической деятельности человека, важную роль играет речь (внешняя и внутренняя).

Специфические особенности произвольного внимания определяют и условие его поддержания. Произвольное внимание, так же как и непроизвольное, тесно связано с чувствами, прежним опытом личности, его интересами. Влияние этих моментов сказывается, однако, при произвольном внимании косвенно, опосредствованно. Так, если непроизвольное внимание обусловлено непосредственными интересами, то при произвольном внимании интересы носят опосредствованный характер. Это интересы цели, интересы результата деятельности. Сама деятельность может не занимать непосредственно, но так как ее выполнение необходимо для решения важной задачи, она становится предметом внимания.

Влияние этих моментов сказывается, однако, при произвольном внимании косвенно, опосредствованно. Так, если непроизвольное внимание обусловлено непосредственными интересами, то при произвольном внимании интересы носят опосредствованный характер. Это интересы цели, интересы результата деятельности. Сама деятельность может не занимать непосредственно, но так как ее выполнение необходимо для решения важной задачи, она становится предметом внимания.

Произвольное внимание социально по своей природе и опосредствовано по структуре.

Послепроизвольное внимание

Ряд психологов выделяют еще один вид внимания, которое возникает после определенных волевых усилий, но когда человек как бы «входит» в работу, легко сосредоточивается на ней. Такое внимание советский психолог И.Ф. Добрынин назвал послепроизвольным (вторичным), так как оно приходит на смену обычному, произвольному вниманию Этот вид внимания отличается от непроизвольного внимания. У человека есть сознательная цель, в которой он сосредоточивается Послепроизвольное внимание имеет большое значение в учебной работе, в начале которой у школьника нередко вызывает произвольное внимание. Затем работа увлекает его, он перестает отвлекаться, начинает заниматься сосредоточенно.

Затем работа увлекает его, он перестает отвлекаться, начинает заниматься сосредоточенно.

Что такое произвольное внимание и как его тренировать

«Будь внимательнее!» — эта фраза все чаще сопровождает растущего ребенка и дома, и в детском саду, и даже во время прогулок на улице.

Взрослый считает ребенка рассеянным и стремится активизировать его внимание. Но если призадуматься, то можно обнаружить в этих же самых высказываниях указание на то, что ребенок очень даже сосредоточен. Просто его внимание направлено не на то, что важно с точки зрения взрослого, а на то, что значимо для него самого.

Внимание — психический процесс, который

обязательно присутствует при познании ребенком мира и проявляется в

направленности и сосредоточенности психики на определенных объектах. Из

огромного потока информации, непрерывно идущей из окружающего мира, благодаря работе

внимания ребенок выбирает ту, которая наиболее интересна, значима и важна для

него. Природа внимания проявляется в том, что выделенный объект, занимая

главное, доминирующее положение, создает в коре головного мозга человека

наиболее сильный очаг нервного напряжения — доминанту. При этом действие всех

остальных раздражителей тормозится. Они не доходят до сознания ребенка, он их

не замечает.

При этом действие всех

остальных раздражителей тормозится. Они не доходят до сознания ребенка, он их

не замечает.

Выделяют несколько типов внимания:

- внешнее внимание , обращенное на предметы и явления окружающего мира, на действия других людей. Данный тип можно замечать уже у младенца. (Поисковые движения глаз, поворот головки в сторону источника света, запаха или звука, замирание и т.д.).

- У дошкольника можно наблюдать и проявление внутреннего внимания , которое направлено на его собственные мысли и переживания. Самым ярким примером этого является ситуация, когда ребенок, забросив все дела, замирает с отрешенным взглядом. Не стоит принимать подобную отрешенность за рассеянность. Наоборот, это кульминация внутреннего внимания.

- Сосредоточенность

и направленность психики может возникнуть в ответ на какой-либо сильный,

необычный, резкий, внезапный раздражитель без каких-либо усилий со стороны

человека. Такое внимание называют непроизвольным .

Оно появляется

вместе с вопросом: «Что это такое?», который возникает, когда мы

сталкиваемся с чем-то новым, необычным. Для ребенка пяти — семи лет такой

вопрос очень актуален. «Обыкновенные чудеса» поджидают

дошкольника в самых разных ситуациях и в самое разное время.

Непроизвольное внимание отличается стихийностью возникновения, отсутствием

усилий для его появления и сохранения. Случайно возникнув, оно может тут

же угаснуть.

Оно появляется

вместе с вопросом: «Что это такое?», который возникает, когда мы

сталкиваемся с чем-то новым, необычным. Для ребенка пяти — семи лет такой

вопрос очень актуален. «Обыкновенные чудеса» поджидают

дошкольника в самых разных ситуациях и в самое разное время.

Непроизвольное внимание отличается стихийностью возникновения, отсутствием

усилий для его появления и сохранения. Случайно возникнув, оно может тут

же угаснуть. - На шестом

году жизни ребенок сам начинает управлять собственным вниманием, заставляя

себя сосредоточиваться на чем-либо важном и нужном, жертвуя занимательным

и интересным. Вид внимания, при котором человек ставит перед собой

сознательную цель сконцентрироваться на чем-либо, называется произвольным .

В этом случае постановка и достижение цели требуют затрат физической

энергии, которую дают эмоции и воля. Ребенок, проявляя произвольное

внимание, расходует не только свое время, но и часть своей энергии. Вот

почему важно благодарить ребенка за проявление произвольного внимания.

Как развивается произвольное внимание? Средства, с помощью которых ребенок начинает управлять своим вниманием, он получает в процессе взаимодействия с взрослыми. Родители, воспитатели включают ребенка в такие новые виды деятельности, как игры по правилам, конструирование и т. п. Вводя ребенка в эти виды деятельности, взрослые организуют его внимание при помощи словесных указаний. Ребенка направляют на необходимость выполнять заданные действия, учитывая те или иные обстоятельства.

Позднее

ребенок начинает сам обозначать словами те предметы и явления, на которые необходимо

обращать внимание, чтобы добиться нужного результата. Так он овладевает одним

из главных средств управления вниманием — умением словесно сформулировать то, на что

он будет ориентироваться . На протяжении дошкольного возраста

использование ребенком речи для организации собственного внимания резко

возрастает. Выполняя задание по инструкции взрослого, дети старшего дошкольного

возраста проговаривают инструкцию в 10-12 раз чаще, чем младшие дошкольники. Таким образом, произвольное внимание формируется в дошкольном возрасте в связи

с общим возрастанием роли речи в регуляции поведения ребенка.

Таким образом, произвольное внимание формируется в дошкольном возрасте в связи

с общим возрастанием роли речи в регуляции поведения ребенка.

- Часто бывает так, что занятия, которые вначале требовали волевых усилий для сосредоточения внимания, становятся затем интересными и увлекают ребенка. Произвольное внимание при этом переходит в послепроизвольное , в котором смешиваются характерные признаки как произвольного, так и непроизвольного внимания. С произвольным послепроизвольное внимание сходно активностью, целенаправленностью, а с непроизвольным — отсутствием усилий для его сохранения.

Таким образом, к пяти-шести годам можно наблюдать развитие произвольного и послепроизвольного внимания.

Тренировка внимания

В 5-7 лет можно заметить, что игры и

любая другая деятельность ребенка стали значительно дольше по времени, чем в

младшем дошкольном возрасте, это говорит о том, что возрастает устойчивость

внимания, которая отвечает за то, как

долго ребенок может поддерживать достаточный уровень сосредоточенности

психики на объекте или выполняемой деятельности. Старшие дошкольники способны

удерживать внимание на действиях, которые приобретают для них интеллектуально

значимый интерес (игры-головоломки, загадки, задания учебного типа). Но существуют

особенности устойчивость внимания дошкольника и условия, при соблюдении которых

оно только возрастет:

Старшие дошкольники способны

удерживать внимание на действиях, которые приобретают для них интеллектуально

значимый интерес (игры-головоломки, загадки, задания учебного типа). Но существуют

особенности устойчивость внимания дошкольника и условия, при соблюдении которых

оно только возрастет:

- Занимайтесь с ребенком без перерыва не больше 35 минут, идеальное время составляет 25 минут.

- Перерывы между занятиями или какой-то деятельности требующей сильно напряжения внимания не должно быть меньше 20 минут.

- Идеальный дни для деятельности, требующей усиленного внимания это вторник и среда.

- Не стоит

перегружать его в выходные занятиями в различных кружках, студиях,

посещением гостей, театров, музеев, просмотром фильмов, компьютерными играми

и так далее. Такое изобилие впечатлений не дает ребенку возможности

сосредоточиться на деятельности, предлагаемой ему в рабочие дни, и так же

может вызвать сонливость, а нервные клетки могут потерять восприимчивость

и перестать отвечать на падающие, на них раздражители.

Чтобы избежать

этого, важно следить за тем, чтобы ребенок соблюдал режим дня ,

особенно в выходные дни.

Чтобы избежать

этого, важно следить за тем, чтобы ребенок соблюдал режим дня ,

особенно в выходные дни.

Существуют так же и другие свойства внимания:

Концентрация внимания определяет, насколько сильно, интенсивно ребенок может сосредоточиться на объекте, а также насколько он способен сопротивляться отвлекающим обстоятельствам, случайным помехам. Чаще всего сила сосредоточения у дошкольников невелика, ее важно развивать. Например, с помощью такого упражнения:

Попробуйте вместе с ребенком разучить какое-нибудь стихотворение при включенном радио или телевизоре. Первое четверостишие учите при очень слабом звуке. Запоминая второе четверостишие, немного увеличьте громкость. Последнее четверостишие разучивайте при достаточно громком звуке.

Переключение

внимания определяется скоростью преднамеренного перехода ребенка с одного объекта или

вида деятельности на другой. При этом перевод внимания всегда сопровождается

некоторым нервным напряжением, которое реализуется волевым усилием.

Распределение внимания предполагает его рассредоточение в одно и то же время на несколько объектов. Именно это свойство дает возможность совершать сразу несколько действий, сохраняя их в поле внимания. В дошкольном возрасте переключение и распределение внимания развиты слабо и требуют тренировки.

Для тренировки переключения и распределения внимания можно использовать такое упражнение:

Ребенку предлагается лист со строчками, состоящими из разных фигур, которые расположены вперемежку: круги, квадраты, прямоугольники, трапеции, овалы и т. п. Дается задание: одну фигуру (например, круг) зачеркивать вертикальной чертой, а другую фигуру (например, треугольник) подчеркивать горизонтальной чертой, все остальные фигуры пропускать.

Психология. Учебник для средней школы. Теплов Б. М.

§23. Непроизвольное и произвольное внимание

Когда человек смотрит в кино интересный фильм, внимание без всяких стараний с его стороны направлено на экран. Когда, идя по улице, он внезапно услышит близко от себя резкий свисток милиционера, он «невольно» обратит на это внимание. Это — непроизвольное внимание, направляющееся на данный объект без нашего сознательного намерения и без всяких усилий с нашей стороны.

Когда, идя по улице, он внезапно услышит близко от себя резкий свисток милиционера, он «невольно» обратит на это внимание. Это — непроизвольное внимание, направляющееся на данный объект без нашего сознательного намерения и без всяких усилий с нашей стороны.

При непроизвольном внимании возникновение участка с оптимальной возбудимостью в коре головного мозга обусловлено непосредственно действующими раздражителями.

Но когда человек должен оторваться от интересной книги и заняться нужной, но мало увлекающей его в данный момент работой, например учить иностранные слова, ему приходится сделать над собой усилие, чтобы направить внимание в эту сторону, и, может быть, ещё больше делать усилий для того, чтобы не позволять вниманию отвлекаться, чтобы поддерживать внимание на этой работе. Если я хочу читать серьёзную книгу, а в комнате громкие разговоры и смех, я должен заставлять себя быть внимательным к чтению и не обращать внимания на разговоры. Такое внимание называется произвольным. Оно отличается тем, что человек ставит себе сознательную цель направить внимание на определённый предмет и для осуществления этой цели применяет, когда это нужно, определённые усилия, старания.

Оно отличается тем, что человек ставит себе сознательную цель направить внимание на определённый предмет и для осуществления этой цели применяет, когда это нужно, определённые усилия, старания.

При произвольном внимании участок с оптимальной возбудимостью поддерживается сигналами, идущими от второй сигнальной системы. Сознательная цель, намерение всегда выражается в словах, чаще всего произносимых про себя (так называемая «внутренняя речь»). Вследствие образовавшихся в прошлом опыте временных связей эти речевые сигналы могут определять перемещение по коре участка с оптимальной возбудимостью.

Способность произвольно направлять и поддерживать внимание развилась у человека в процессе труда, так как без этой способности невозможно осуществлять длительную и планомерную трудовую деятельность. Во всяком деле, как бы человек ни любил его, всегда имеются такие стороны, такие трудовые операции, которые сами по себе не имеют ничего интересного и не способны привлечь к себе внимание.

Необходимо уметь произвольно сосредоточивать своё внимание и на этих операциях, необходимо уметь заставить себя быть внимательным и к тому, что в данный момент не привлекает к себе. Хороший работник — это тот человек, который всегда может сосредоточить своё внимание на том, что необходимо по ходу работы.

Хороший работник — это тот человек, который всегда может сосредоточить своё внимание на том, что необходимо по ходу работы.

Сила произвольного внимания человека бывает очень велика. Опытные артисты, лекторы, ораторы хорошо знают, как трудно бывает начать играть, говорить речь или читать лекцию при сильной головной боли. Представляется, что при такой боли невозможно будет довести выступление до конца. Однако стоит только усилием воли заставить себя начать и сосредоточиться на содержании лекции, доклада или роли, как боль забывается и снова напоминает о себе только по окончании выступления.

Какие же предметы способны привлекать к себе наше непроизвольное внимание? Иначе говоря: каковы причины непроизвольного внимания?

Причины эти очень многочисленные и разнообразные, можно разделить на две категории: во-первых, внешние особенности самих объектов и, во-вторых, интересность этих объектов для данного человека.

Всякий очень сильный раздражитель обычно привлекает внимание. Сильный удар грома обратит на себя внимание даже очень занятого человека. Решающее значение имеет при этом не столько абсолютная сила раздражителя, сколько его относительная сила по сравнению с другими раздражителями. В шумном цехе завода голос человека может остаться незамеченным, тогда как среди полной тишины ночи даже слабый скрип или шорох могут привлечь внимание.

Сильный удар грома обратит на себя внимание даже очень занятого человека. Решающее значение имеет при этом не столько абсолютная сила раздражителя, сколько его относительная сила по сравнению с другими раздражителями. В шумном цехе завода голос человека может остаться незамеченным, тогда как среди полной тишины ночи даже слабый скрип или шорох могут привлечь внимание.

Внезапное и непривычное изменение также привлекают внимание. Например, если в классе со стены будет снята старая стенгазета, висевшая долгое время и уже переставшая привлекать внимание, то её отсутствие на привычном месте на первых порах будет обращать на себя внимание.

Главную роль в привлечении непроизвольного внимания играет интересность объекта для данного человека. Что же является интересным?

Прежде всего то, что близко связано с жизненной деятельностью человека и стоящими перед ним задачами, с той работой, которой он увлечён, с теми мыслями и заботами, которые эта работа в нём возбуждает. Человек, захваченный каким-нибудь делом или какой-нибудь идеей, интересуется всем тем, что с этим делом или с этой идеей связано, и, следовательно, на всё это обращает внимание. Учёный, работающий над какой-либо проблемой, сразу обратит внимание на, казалось бы, мелкую деталь, которая ускользает от внимания другого человека. Один из крупных советских изобретателей говорит о себе: «Меня интересуют принципы всех машин. Еду на трамвае и смотрю в окно, как идёт автомобиль, как он поворачивается (тогда я думал об управлении для культиватора). Я смотрю на все машины, например на лестницу пожарную, и вижу, что и её можно использовать».

Учёный, работающий над какой-либо проблемой, сразу обратит внимание на, казалось бы, мелкую деталь, которая ускользает от внимания другого человека. Один из крупных советских изобретателей говорит о себе: «Меня интересуют принципы всех машин. Еду на трамвае и смотрю в окно, как идёт автомобиль, как он поворачивается (тогда я думал об управлении для культиватора). Я смотрю на все машины, например на лестницу пожарную, и вижу, что и её можно использовать».

Конечно, люди интересуются и не только тем, что непосредственно связано с главным делом их жизни. Мы читаем книги, слушаем лекции, смотрим спектакли и кинофильмы, которые не имеют прямой связи с нашей работой. Что же требуется для того, чтобы они могли заинтересовать нас?

Во-первых, они должны быть в какой-то мере связаны с уже имеющимися у нас знаниями; предмет их не должен быть для нас совершенно неизвестным. Едва ли человек, никогда не изучавший физики звука и ничего не понимающий в технологии металлов, может заинтересоваться лекцией на тему «Применение ультразвуков в металлургии».

Во-вторых, они должны давать нам какие-либо новые знания, содержать в себе нечто для нас ещё неизвестное. Популярная лекция на только что названную тему не будет интересна для специалиста по ультразвукам, так как содержание её известно ему целиком.

Интересно главным сбразом то, что даёт новые сведения о вещах, с которыми мы уже знакомы, в особенности же то, что даёт ответы на уже имеющиеся у нас вопросы. Интересно то, чего мы ещё не знаем, но что мы уже хотим узнать. На этом принципе построены обыкновенно сюжеты интересных, увлекательных романов. Автор так ведёт рассказ, что перед нами встаёт ряд вопросов (кто совершил такой-то поступок? что случилось с героем?), и мы постоянно ожидаем получить на них ответ. Поэтому внимание наше находится в постоянном напряжении.

Интерес является самым важным источником непроизвольного внимания. Интересное увлекает, захватывает наше внимание. Но было бы совсем неверно думать, что произвольное внимание никак с интересом не связано. Оно тоже руководствуется интересами, но интересами другого рода.

Если увлекательная книга захватывает внимание читателя, то тут имеет место непосредственный интерес, интерес к самой книге, к содержанию её. Но если человек, задавшись целью построить модель какого-нибудь аппарата, производит для этого длинные и сложные вычисления, каким интересом он при этом руководствуется? Непосредственного интереса к самым вычислениям у него нет. Интересует его модель, и вычисления являются лишь средством для того, чтобы её построить. В этом случае человек руководствуется косвенным, или, что то же самое, опосредствованным интересом.

Такого рода косвенный интерес, интерес к результату, имеется почти во всякой работе, которую мы производим сознательно и добровольно; иначе мы не стали бы её производить. Его достаточно, чтобы взяться за работу. Но так как самая работа неинтересна, не увлекает нас, то мы должны употреблять усилие, чтобы сосредоточить на ней своё внимание. Чем меньше самый процесс работы интересует и увлекает нас, тем более необходимо произвольное внимание. Иначе мы никогда не достигнем интересующего нас результата.

Иначе мы никогда не достигнем интересующего нас результата.

Бывает, однако, так, что работа, за которую мы сначала взялись вследствие какого-либо косвенного интереса и на которой мы сначала должны были произвольно, с большим усилием удерживать внимание, постепенно сама начинает интересовать нас. Возникает непосредственный интерес к работе, и внимание начинает уже непроизвольно сосредоточиваться на ней. Это — нормальное течение внимания в трудовом процессе. С помощью одних произвольных усилий, без всякого непосредственного интереса к самой деятельности нельзя успешно работать в течение долгого времени, так же как нельзя вести длительную работу на основе одного лишь непосредственного интереса и непроизвольного внимания; время от времени необходимо вмешательство произвольного внимания, так как в силу усталости, скучного однообразия отдельных этапов, всякого рода отвлекающих впечатлений непроизвольное внимание будет ослабляться. Итак, выполнение всякой работы требует участия и произвольного и непроизвольного внимания, постоянного чередования их.

В итоге мы можем сказать: центральное значение в организации внимания имеют задачи, которые ставят перед нами жизнь и та деятельность, которой мы заняты. Исходя из этих задач, мы сознательно направляем своё произвольное внимание, этими же задачами определяются наши интересы — главные двигатели непроизвольного внимания.

Из книги Общая психология автора Первушина Ольга НиколаевнаВНИМАНИЕ Вниманием называется выделение, выбор актуальных, личностно значимых сигналов. Как и память, внимание относится к так называемым «сквозным» психическим процессам, так как присутствует на всех уровнях психической организации.Традиционно внимание связывают

Из книги Психология автора Крылов Альберт АлександровичГлава 25. ВОЛЯ КАК ПРОИЗВОЛЬНОЕ УПРАВЛЕНИЕ ПОВЕДЕНИЕМ § 25.1. ВОЛЯ КАК ПСИХОФИЗИОЛОГИЧЕСКИЙ ФЕНОМЕНВ процессе эволюции нервная система становится не только органом отражения окружающей действительности и состояний животных и человека, но и органом их реагирования на

Из книги Мой метод: начальное обучение автора Монтессори МарияВнимание

Чего мы прежде всего ждем от ребенка, помещенного в обстановку внутреннего роста: вот он сосредоточит свое внимание на каком-либо предмете, использует этот предмет в соответствии с его назначением и будет бесконечно повторять упражнения с данным предметом. Один

Один

Внимание Искусство — это хореография внимания.Вы стоите перед красивым зданием. Оно представляется вам осмысленным целым. Затем ваше внимание переключается на колонны, расположение окон, козырек крыши, затем обратно на здание в целом, потом вновь на подробности:

Из книги Социальное влияние автора Зимбардо Филип Джордж Из книги Психология: Шпаргалка автора Автор неизвестен Из книги Элементы практической психологии автора Грановская Рада МихайловнаВнимание Вот какой рассеянный С улицы Бассейной! С.

Из книги Шпаргалка по общей психологии автора Войтина Юлия Михайловна57. НЕПРОИЗВОЛЬНОЕ ВНИМАНИЕ Непроизвольное внимание – это внимание, возникающее без всякого намерения человека, без заранее поставленной цели, не требующее волевых усилий.Существует сложный комплекс причин, вызывающих непроизвольное внимание. Эти причины можно

Из книги Психология воли автора Ильин Евгений ПавловичГлава 2. Воля как произвольное управление поведением и деятельностью

Воля как произвольное управление поведением и деятельностью

2.3. Воля — это волевая регуляция или произвольное управление? Трудно сказать по какой причине, но в психологии утвердилось понятие «психическая регуляция», а не «психическое управление». Поэтому, очевидно, применительно к воле в большинстве случаев психологи говорят о

Из книги Квантовый ум [Грань между физикой и психологией] автора Минделл Арнольд3.2. Функциональные системы и произвольное управление действиями и деятельностью Со времен И. П. Павлова понимание физиологических механизмов управления поведением значительно продвинулось. Представление о рефлекторной дуге было заменено на представления о

Из книги Флипноз [Искусство мгновенного убеждения] автора Даттон Кевин5.3. Произвольное внимание как инструмент самоконтроля

Получение информации по каналам «обратной связи» и ее анализ возможны только в том случае, если в процесс управления и регуляции включено произвольное внимание. Как и непроизвольное внимание, произвольное внимание

Как и непроизвольное внимание, произвольное внимание

Внимание Истинная ценность понимания заключается в том, что оно мотивирует вас быть более внимательным ко всему. Мы знаем по собственному опыту: обратив на что-то внимание, мы начинаем воспринимать это по-другому. Так, бездумное поглощение пищи вызывает у нас совершенно

Из книги автора Из книги автораВнимание Ежечасно, ежеминутно тысячи внешних стимулов лезут нам в глаза и уши, затопляя наши мозги. При этом осознаем мы – просто обращаем внимание – лишь горстку из них. Присмотритесь к тому, что вы делаете прямо сейчас, например, читая эту книгу. Поднимая глаза от текста,

Виды внимания, типы и свойства: произвольное, непроизвольное

Внимание – это когда человек избирательно направляет и сосредотачивает свое сознание на объекте или определенной деятельности. У индивида при этом повышается сенсорная и двигательная, и интеллектуальная активности. У внимательности основа органическая, представляющая особую структуру мозга, обеспечивающая функционирование этого параметра и отвечающая за проявление характеристик внешнего плана. В мозге за внимательность отвечают особые клетки – нейроны, которых специалисты называют ещё детекторами новизны.

У внимательности основа органическая, представляющая особую структуру мозга, обеспечивающая функционирование этого параметра и отвечающая за проявление характеристик внешнего плана. В мозге за внимательность отвечают особые клетки – нейроны, которых специалисты называют ещё детекторами новизны.

Для чего нужна внимательность?

Отвечают на данный вопрос функции, осуществляемые вниманием. Важность внимательности можно обозначить на простейших ситуативных примерах из ежедневной деятельности человека, проиллюстрировав произведение о «рассеянном с улице Бассейной». Так, невнимательность может привести к совершению ошибочных действий. При некоторых психических расстройствах невнимательной в крайних ее проявлениях выступает в качестве симптома недуга. Невнимательность у детей может свидетельствовать о замедленных процессах развития. Так, может быть нарушено произвольное внимание.

Психологи выделяют следующие основные функции:

- бдительность;

- реакция на сигналы и их обнаружение;

- функции поиска;

- избирательность;

- распределение.

Бдительность важна при обеспечении чувств личной безопасности. Функции поиска также напрямую связаны с внимательностью. Так, развитию этого качества посредством поиска способствует такая простая школьная методика, как работа над ошибками и проверка собственной работы на предмет их наличия. Это не просто развивает внимательность, а формирует непроизвольное внимание.

Важна внимательность в сфере интеллектуальной работы. С целью выявления степени его сформированности и развитости, используются различные методики.

Кроме того, в психологии используется такие понятие, как признаки внимания. К их числу можно отнести пантомические особенности поведения: замирание, задержка дыхания или его замедление, проявляющиеся в сосредоточенности на определенном объекте, при интеллектуальной работе. Так, сегодня в числе наиболее изученных – зрительное внимание. Признаком его проявления является созерцание или разглядывание видимых предметов, способность к запоминанию их расстановки или внешних особенностей. Развивают зрительное внимание детей посредством цвета или формы. Развитие слухового внимания основывается на способностях к запоминанию звуков, произношений.

Развивают зрительное внимание детей посредством цвета или формы. Развитие слухового внимания основывается на способностях к запоминанию звуков, произношений.

Внимательность во всем своем многообразии

Такой параметр, как внимательность, в рамках психологической науки также подвержено классификации. Выделяют следующие виды внимания:

- непроизвольное;

- произвольное;

- послепроизвольное.

В основе классификации заложены принципы сознательности выбора, его направленности и регуляции. Также важно упомянуть, что нижеописанные виды внимания никак нельзя рассматривать по отдельности.

Непроизвольное внимание

Чтобы оно себя проявило, человеку не требуется прилагать особых усилий. Достаточно какого-то сильного раздражителя в виде нового, вызывающего интерес. Ключевой функцией непроизвольного внимания считается возможность человека быстро и адекватно ориентироваться при постоянно изменяющихся параметрах окружающего мира, выделяя объекты, имеющие важное значение в жизненном, личностном плане.

Непроизвольное внимание в медицине представлено несколькими синонимами – пассивная внимательность или эмоциональная. Этим подчеркивается, что у индивидуума отсутствуют усилия, направленные на сосредоточение на объекте. Отмечается наличие связи между объектами внимания и его эмоциями.

Произвольное внимание

Имеет также следующие синонимы в литературе – активное или волевое. Данному типу характерно целенаправленное сосредоточение сознания вкупе с усилиями воли. Человек, поставивший перед собой некую задачу и осознанно вырабатывающий программу по ее достижению, запускает свое произвольное внимание. А оно начинает регулировку протекающих в мозгу психических процессов. Чем сильнее воля у индивидуума, тем больше сил он сможет мобилизовать на решение поставленных задач. Благодаря этой функции, человек может извлекать из своей памяти только необходимую для этого информацию, выделяя из всего объема памяти самое главное.

На основании этой особенности работает и развитие произвольного внимания. Обычный человек без специальных тренировок способен использовать его около 20 минут.

Послепроизвольный вид

Послепроизвольный вид возникает в ситуациях, когда задача из первостепенной переходит в обыденную. Как пример можно привести школьника с его домашними заданиями. В первое время он усилием воли садится за их выполнение, но постепенно этот процесс становится обыденностью, и для его выполнения не нужно волевого усилия с его стороны. Послепроизвольный вид – это привычка к чему-то.

По психологическим характеристикам данный вид несколько схож с непроизвольным. Длительность проявления послепроизвольной внимательности может равняться нескольким часам. Его активно используют в педагогической практике, искусственно вводя школьников в состояние послепроизвольного внимания.

Другие виды и свойства внимания

Кроме этих вышеописанных, относящихся к основным, существует еще несколько:

- Природное внимание – дается человеку с рождения. Оно выражается в избирательном реагировании индивидуума на стимулы с элементами новизны. И неважно внутренние они или внешние. Основной процесс, обеспечивающий данные типы внимания, частности их деятельность – это ориентировочный рефлекс;

- Социально обусловленное внимание является результатом обучения и воспитания человека. Имеет тесную связь с регуляцией поведения при помощи воли и сознательно-избирательным реагированием на объект внимания;

- Непосредственное внимание – управляется только тем объектом, на которое оно направлено и если объект внимания полностью соответствуют потребностям и интересам человека в данный момент;

- Опосредствованное внимание. Ее регуляция происходит при помощи специальных средств, в число которых входят жесты, слова, указующие знаки или предметы;

- Чувственное внимание – является частью с эмоциональности человека и избирательной деятельностью его органов, отвечающих за чувства;

- Интеллектуальное внимание контактирует направленностью и сосредоточенностью человеческой мысли.

Свойства и проявления внимательности не подвержены классификации. А наблюдать их можно в ходе интеллектуальной деятельности. Так, это способность к сосредоточенности, переключения с одного вида деятельности на другую работу. Учитывается и такая характеристика, как интенсивность. Она зависит от психологической значимости и важности для индивидуума интеллектуальной или иной деятельности.

Концентрированность – способность сосредоточения на конкретном объекте в течение длительного периода времени, является одним из основных признаков внимательности.

Развитие внимание

Практически все формы внимания можно развивать. Этому способствует учебная, интеллектуальная и трудовая деятельность человека. При этом рекомендуется создавать для него условия, способствующие формированию:

- интеллектуальная работа в условиях отвлекающих факторов, при этом, добиваясь того, чтобы человек на них не отвлекался;

- добиться от человека того, чтобы он осознал, что осваиваемый им труд имеет общественное значение, и он должен нести ответственность за выполненную им работу;

- распределение и объем внимания можно сформировать в качестве определенного трудового навыка или интеллектуальной деятельности путем одновременного выполнения нескольких действий в условиях, когда темп деятельности нарастает. Таким способом развивают, например, зрительное внимание. Присутствует и классификация по степени сложности различных методик.

Устойчивость внимательности можно обеспечивать развитием волевых качеств индивида. Переключение развивается подбором специальных упражнений. Метод нередко применяется, когда важно развитие произвольного внимания. Единственное условие обучения – это делать любую работу качественно.

Автор статьи: Сюмакова СветланаУпражнения для тренировки памяти и внимания

Подготовка к экзамену — это самый важный этап, без которого нельзя сдать ОГЭ и ЕГЭ. Для эффективной подготовки психологами было создано большое количество развивающих упражнений, которые способны улучшить такие необходимые навыки, как память, внимание и концентрация. В этой статье будут приведены факты, благодаря которым подготовка к ЕГЭ будет простой и эффективной.

Развитие памяти и внимания

Чтобы информация запоминалась проще и быстрее, нужна тренировка памяти. Для этого ученые и психологи создали многочисленные тесты и упражнения.

Улучшают память с помощью разных мнемотехник. Например, банальное подчеркивание в тетради важных дат и обведение в рамочку формулы концентрирует мозг на этом выделении и помогает лучше на нем сфокусироваться.

Развитие внимания — это пункт, без которого нельзя обойтись. На внимании основан успех запоминания большого объема информации.

Особенности развития внимания и памяти

Тренировку памяти лучше начать после прохождения теста, который бы показал насколько эффективно вы пользуетесь памятью, и какой вид памяти у вас лучше всего развит.

Существует 4 вида памяти:

- Зрительная — это то, как вы запомнили информацию в образной форме, которую вы увидели.

- Слуховая — это запоминание услышанной информации.

- Двигательная — отвечает за ваши конспекты и ведение тетради. Люди с двигательной памятью хорошо запоминают информацию только, если запишут ее.

- Комплексная — это память, объединяющая в себе 2 или 3 вышеперечисленных вида.

Особенности занятий заключаются в индивидуальном подходе к каждому виду памяти. Упражнения нужно открывать только после прохождения теста и выявления более развитого вида памяти у занимающегося. Таким образом человек может развить любой тип своей памяти.

Виды внимания

Внимание — это процесс мозговой активности, способность концентрации на чем-либо. Психологи выделяют 3 вида внимания: непроизвольное, произвольное и послепроизвольное.

Непроизвольное

Непроизвольное внимание возникает неожиданно, независимо от сознания. Оно не требует каких-то волевых усилий. Его еще называют пассивным или вынужденным вниманием. Примером такого вида можно привести ситуацию с громкими звуками, яркими вспышками, когда человек невольно и несознательно обращает внимание на подобные раздражители.

Произвольное

Произвольный — это вид внимания, когда человек подсознательно концентрируется на чем-либо. Произвольное внимание в основном требует волевых усилий. В качестве примера можно привести ситуацию, когда ученик прикладывает усилия, чтобы не уснуть и доделать домашнюю работу.

Послепроизвольное

Послепроизвольный вид, как и произвольный, носит подсознательный характер, но при этом не требует особых волевых усилий. Управляется чаще интересом. Как пример, можно привести прочтение книги. Изначально человек концентрируется на сюжете с помощью волевых усилий, но затем интерес погружает индивида в чтение, и ему уже не нужно делать над собой усилия, чтобы закончить книгу.

Упражнения на развитие внимания и концентрации

Упражнение «Линия»

Возьмите белый лист бумаги и начните медленно рисовать прямую линию. Все ваши мысли должны быть сосредоточены только на этой линии, если вы отвлекаетесь на что-то еще, то делайте маленькую черту вверх, как на кардиограмме. Высоким результатом концентрации будет результат, где в течение 3 минут вы не сделаете ни одной черты вверх.

Упражнения на развитие памяти

Упражнения, рекомендованные психологами и учеными.

Для развития зрительной памяти

Лучше всего подойдет игра «Найди 10 отличий». Достаточно простое развлечение, но для тех, кто не обладает достаточным вниманием и концентрацией, эта игра может показаться не такой уж и легкой. Доступность ее в виде приложения на гаджетах также является большим плюсом.